此篇文章是为你整理一份由浅入深的完整机器学习学习综述资料,覆盖理论与应用两个角度,涵盖NLP、CV、RAG、Agent等重点领域,并提供推荐学习资料。目标是帮助你在短时间内建立从全局认知到实战技能的完整体系。

机器学习(Machine Learning)是人工智能领域中的核心分支,通过让机器从数据中自动学习规律来完成预测、决策等任务。对于有一定编程经验但未系统学习过机器学习的开发者来说,构建完整的知识体系并掌握实践技巧,有助于在短时间内从基础入门并逐步深入。本综述将从理论基础和应用技巧两个角度,由浅入深地介绍机器学习的重要概念、算法原理、模型评估方法、优化技巧,以及深度学习框架与前沿应用,涵盖自然语言处理、计算机视觉、检索增强生成(RAG)、Agent系统、多模态处理等领域,最后推荐学习资源,帮助读者高效地冲刺机器学习领域的系统学习。

基础理论与算法

本章节将介绍机器学习的基本概念和常用算法,为深入学习打下理论基础。我们将讨论机器学习的主要范式(监督、无监督、强化学习)、模型泛化与偏差-方差权衡,以及线性回归、决策树等经典算法的原理和比较。此外,还将介绍模型评估指标和验证方法、模型训练的优化算法,以及特征工程、正则化、集成学习等提升模型性能的技巧,最后简要概述强化学习的基本框架。

机器学习基本概念

监督学习 vs 无监督学习 vs 强化学习: 根据训练数据是否带有标签以及学习的机制不同,机器学习主要分为几类。

- 监督学习(Supervised Learning)是指算法在带标注的数据上训练,从已知的输入-输出对学习映射关系,然后对新输入预测输出。典型的监督学习任务包括分类(预测离散标签)和回归(预测连续值)。

- 无监督学习(Unsupervised Learning)则在无标签的数据上学习数据的内在结构,如聚类发现相似数据点、降维提取主成分等。无监督学习没有显式的正确答案,引导算法寻找模式。

- 强化学习(Reinforcement Learning)不同于前两者,它通过“智能体”(agent)在环境中不断试错来学习策略:智能体采取动作,环境反馈奖励或惩罚,智能体据此更新策略,目的是累积最大化长期奖励。在强化学习中,模型通过与环境交互自主学习,不需要每一步都有监督信号。

训练集、验证集与测试集: 为了评估模型的泛化能力,通常将数据集划分为

- 训练集(用于训练模型参数)

- 验证集(调参与模型选择)

- 测试集(最终评估模型性能)。

模型应该在训练集上学到规律,同时在未见过的数据(测试集)上表现良好。

如果模型在训练集上表现很优秀却在测试集上效果很差,则发生了过拟合。

过拟合与欠拟合:

- 过拟合(overfitting)指模型把训练数据学得过于“严格”,连同数据中的噪声或偶然模式也记住了,导致在新数据上表现不佳。

- 欠拟合(underfitting)则是模型过于简单,无法捕获训练数据中的真实模式,两种情况都会降低泛化性能。

理想情况下,模型在训练集和测试集上都能取得较低的误差,这需要在模型复杂度与训练数据规模之间取得平衡。

泛化与偏差-方差权衡:

- 模型对新数据的适应能力称为泛化能力。影响泛化的一个重要概念是偏差-方差权衡(Bias-Variance Tradeoff)。

- 偏差表示模型预测的系统误差,偏差高通常意味着模型过于简单,无法充分学习数据(欠拟合)。

- 方差表示模型预测的波动性,方差高通常意味着模型对训练数据的细微变化过于敏感(过拟合)。偏差和方差常常此消彼长:复杂模型偏差低但方差高,简单模型偏差高但方差低。我们需要在两者之间找到折中,使得总误差最低。

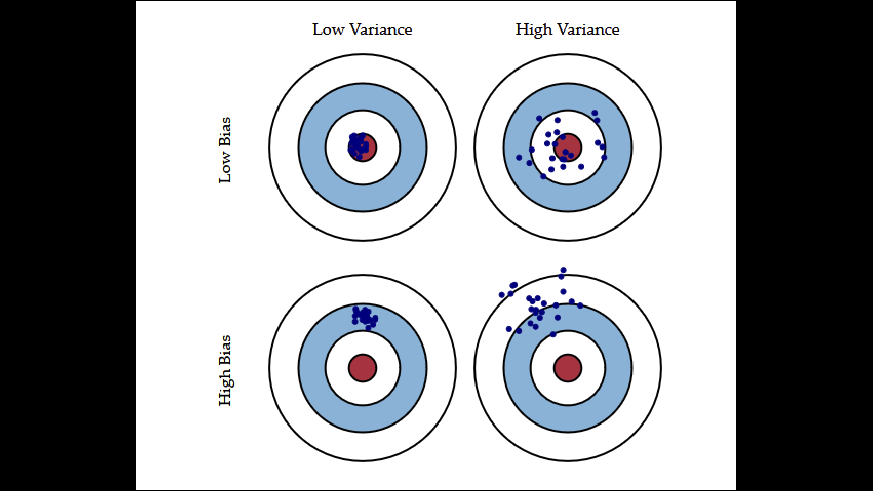

(📌Bias Variance Tradeoff in Machine Learning)

偏差-方差权衡示意图:下图通过靶心图形象展示了模型复杂度对偏差和方差的影响。其中每个小蓝点代表模型一次预测的结果位置,红色圆心表示目标值。

- 左上角表示低偏差、低方差的理想情况,预测点集中且围绕目标值;

- 右上角表示低偏差、高方差的情形,预测结果分布在目标附近但散布较广;

- 左下角表示高偏差、低方差,预测集中但偏离目标;

- 右下角表示高偏差、高方差,预测既分散又偏离目标。

实际中,我们希望模型达到左上角的状态,即保证足够复杂度来降低偏差,同时通过正则化等手段控制方差,使模型对新样本有良好的泛化能力。

常见算法原理概览

机器学习领域诞生了众多算法。这里我们介绍几种经典的、有代表性的算法,包括线性回归、逻辑回归、决策树、支持向量机、k近邻、朴素贝叶斯以及聚类方法,并比较它们的原理与适用场景。

-

线性回归(Linear Regression): 线性回归是最基本的回归算法,用于预测连续数值。它假设输出与输入特征是线性关系,即

y = w_1 x_1 + w_2 x_2 + ... + w_n x_n + b训练线性回归本质上是求解模型参数

w_i和截距b,使预测值与真实值之间的均方误差(MSE)最小。可以通过解析解(如正规方程)或梯度下降迭代优化参数。线性回归模型简单且易于解释,计算高效,对线性可分的数据效果好。然而它无法处理复杂的非线性关系,容易受异常值影响,且假设特征和输出呈线性独立关系,有时这一假设不成立需要对特征做多项式扩展等处理。 -

逻辑回归(Logistic Regression): 尽管名为“回归”,逻辑回归实际上是用于二分类任务的分类算法。它利用逻辑函数(sigmoid函数)将线性回归的输出映射到0~1之间的概率值,再根据阈值判定类别。形式上,模型输出

\hat{y} = \sigma(w \cdot x + b),其中\sigma(z) = \frac{1}{1+e^{-z}}。训练时通常使用对数损失(log loss)或交叉熵损失,通过极大似然估计和梯度下降来优化参数。逻辑回归适用于特征和输出近似线性可分的情况,具有概率输出、实现简单、可解释性强(通过权重大小看出特征对结果的影响)。但与线性回归类似,它只能拟合线性决策边界,处理非线性复杂数据时表现欠佳,可以通过核方法或特征组合来增强其能力。 -

决策树(Decision Tree): 决策树是一种树形结构的非线性模型,可用于分类和回归。它通过对特征空间进行递归划分来学习决策规则。训练时,算法在当前数据集上选择一个特征及其某个阈值(或类别)来划分数据,使得划分后的子集在目标变量上尽可能纯净(比如分类常用信息增益或基尼不纯度来选择最优划分)。这个过程递归进行,在每个子节点继续选择特征划分,直到达到停止条件(如叶节点样本数太少或没有明显的信息增益)。决策树的优点是易解释(可以可视化为if-else规则)、对数据分布无过多假设,对异常值和缺失值不敏感,能处理非线性关系。但单棵树容易过拟合,泛化性能不稳定,需要通过剪枝(提前停止生长或事后修剪)来控制复杂度。此外,决策树对小的扰动较敏感(数据稍有变动可能树结构就不同),所以常结合集成方法提高稳定性(如随机森林就是集成许多决策树)。

-

支持向量机(SVM, Support Vector Machine): SVM是一种强大的分类模型(也可用于回归,称为支持向量回归SVR)。基本的线性SVM尝试在样本间找到一个最大间隔的分离超平面:也就是不仅分类正确,而且希望决策边界离各类别的最近样本(支持向量)有尽可能大的距离,以提高泛化力。其核心思想是通过求解一个凸优化问题来最大化间隔,同时对分类错误给予惩罚(软间隔SVM引入松弛变量和惩罚系数C)。对于线性不可分的数据,SVM使用核技巧(Kernel Trick)将原始特征映射到高维空间,使数据在高维空间中线性可分,比如常用的高斯核、多项式核等。SVM在相当长时间内曾是流行的通用分类方法,对中小规模数据有良好表现,尤其是在特征空间复杂但维度不高的情况下。它的决策边界由少数支持向量决定,具有一定解释性和对噪声的鲁棒性。缺点是对大规模数据训练较慢(时间和内存复杂度较高),对参数(如核函数参数和惩罚系数)较为敏感需要调节,输出仅给出类别决策本身而非概率。此外,在非常高维(如文本)或数据量非常大时,SVM的效率和效果可能不如简单模型或深度学习模型。

-

k近邻(k-Nearest Neighbors, kNN): kNN是最简单的机器学习方法之一,属于基于实例的学习(懒惰学习)算法。它在训练阶段并不显式建模或拟合参数,只是简单地记忆所有训练样本。预测时,对于一个新的输入样本,计算它与训练集中所有样本的距离(通常使用欧氏距离或曼哈顿距离等度量),选取最近的k个邻居,然后通过多数投票(分类)或均值(回归)来决定预测结果。由于直接利用训练数据,相当于假设输入空间相近的点其输出也相近。kNN的优点是实现简单、对复杂决策边界有天然的刻画能力(因为非参数),无需显式训练过程。然而,它存储和计算代价高:需要保留全部数据,且每次预测都要计算与所有样本的距离,随数据量增大而变慢。此外,kNN对不同尺度的特征需要注意标准化,否则距离计算可能被某些尺度大的特征主导;对噪声和不相关特征也比较敏感,因为它机械地使用邻近样本。选择合适的k值也很关键:k过小容易受局部噪声影响(方差高),k过大又可能引入过多远的点导致欠拟合(偏差高)。尽管如此,kNN在一些低维、小数据集的任务中作为基准表现不错,也常用于多分类(可以自然处理多于两类的情况)。

-

朴素贝叶斯(Naive Bayes): 朴素贝叶斯是基于概率统计的分类方法,利用贝叶斯定理计算后验概率并做出分类决策。具体来说,对于一个待分类样本,计算其属于每个类别C的概率

P(C|X),并选取概率最大的类别作为预测。根据贝叶斯定理,P(C|X) \propto P(X|C)P(C),其中P(C)是先验概率,P(X|C)是似然。朴素贝叶斯算法之所以称为“朴素”,在于它假设特征之间条件独立:即给定类别C时,样本的各特征分量是相互独立的。这个假设在现实中往往不严格成立,但在实践中朴素贝叶斯仍常有不错的效果,特别是文本分类领域(如垃圾邮件识别),因为文本词汇很高维且每个词出现与否相对独立。根据特征类型不同,有不同版本的朴素贝叶斯分类器:如高斯贝叶斯用于连续特征(假定各类别上特征服从正态分布)、多项式贝叶斯用于离散计数特征(常用于文本词频)、伯努利贝叶斯用于二元特征。朴素贝叶斯的优点是速度快、所需样本量小,对高维数据表现良好,模型也易于更新(先验和似然可累积计算)。缺点是独立性假设有时过于简化,如果特征相关性强会影响效果。此外,它是一种线性分类器(对数概率是线性函数),复杂决策边界上效果有限。总的来说,朴素贝叶斯在资源受限场景或作为基线模型很有价值。 -

聚类(Clustering): 聚类是无监督学习中的典型任务,旨在将数据集划分为若干组,使得同一簇内的数据相似度高,不同簇之间差异大。常见的聚类算法包括K均值(K-Means)、层次聚类(Hierarchical Clustering)等。K均值聚类预先指定簇的数目K,算法随机初始化K个簇中心,然后反复迭代:将每个样本指派到最近的簇中心,更新簇中心为簇内样本的均值,如此直到簇分配不再变化或达到迭代次数上限。K均值简单高效,但需要选择K值且可能收敛到局部最优(对初始值敏感),通常会多次运行取最佳结果。层次聚类则不需预先指定簇数,它建立一个簇的树形划分(聚类树):凝聚式层次聚类从每个样本自成一类开始,不断合并最近的两类直到达成一个大簇;分裂式层次聚类反过来,从整体一个簇开始不断细分。层次聚类生成的树可以通过剪切得到不同数目的簇,具有一定的可解释性,但计算复杂度较高(尤其凝聚式需要计算距离矩阵)。聚类算法在探索数据结构、异常检测等方面很有用,不过由于无监督性质,评估聚类结果质量有一定挑战,通常依赖领域知识或使用轮廓系数等内部指标。

以上算法各有优缺点和适用场景。一般来说,线性回归和逻辑回归适用于简单可线性分的数据,朴素贝叶斯在文本等高维独立假设近似成立的场景下表现突出,kNN在小数据和概念上简单的问题上可作为基准,决策树和SVM能处理较复杂关系的数据但需要注意调参和规模限制,聚类算法用于事先未标记的数据探索。有时候,我们也会将多种算法配合使用,例如用聚类结果作为新的特征给监督模型,或者先用简单模型得到基线再尝试复杂模型。选择算法时应考虑数据规模、特征性质、问题类型以及对模型可解释性或性能的要求。

模型评估与验证

训练出一个模型后,如何判断它的好坏?这需要科学的评估指标和验证方法。不同任务有不同指标,此节将介绍分类和回归常用的性能指标、混淆矩阵以及交叉验证等模型验证方法。

混淆矩阵(Confusion Matrix): 对于分类任务,特别是多分类,混淆矩阵是评估结果的基本工具。它以矩阵形式列出真实标签与模型预测标签的对应情况。例如,对于二分类,混淆矩阵是2x2的表,包括True Positive(TP,正类被正确预测为正)、True Negative(TN,负类被正确预测为负)、False Positive(FP,负类被错误预测为正,又称类型I错误)、False Negative(FN,正类被错误预测为负,类型II错误)。通过混淆矩阵我们可以进一步计算多种评估指标。📌

混淆矩阵示例:上图显示了一个三类分类问题的混淆矩阵。行表示实际类别(Cat猫,Dog狗,Horse马),列表示模型预测类别。对角线上的数值(猫=8,狗=10,马=8)是模型正确分类的样本数量,非对角则是错误分类情况。例如,该模型将2个实际为狗的样本误判为猫(第二行第一列的2),将1个实际为猫的样本误判为狗(第一行第二列的1)等。混淆矩阵提供了分类结果的全面描述,有助于分析哪些类别容易混淆,从而针对性改进模型或数据。

准确率(Accuracy): 最常用的分类指标,等于正确预测数占总样本数的比例,即 (TP+TN)/(TP+TN+FP+FN)。准确率直观易懂,但在类别不平衡的情况下可能具有误导性。例如,如果99%的样本是负类,那么即使模型把所有样本都预测为负(TN很多,TP为0),准确率依然很高(99%),却忽略了正类的识别率。因此,当类分布不均衡时,需要结合其他指标看待模型表现。

精确率和召回率(Precision & Recall): 这是一对在二分类中特别重要的指标,尤其用于不平衡数据或关注正类识别性能的任务。精确率(Precision)定义为模型判定为正的预测中实际为正的比例,即 P = TP/(TP+FP)。它衡量的是模型预测出的正类结果有多少是准确的,FP越多则精确率越低。召回率(Recall)也称灵敏度(Sensitivity),定义为实际为正的样本中被模型正确识别为正的比例,即 R = TP/(TP+FN)。它衡量正类样本被模型捕获的程度,FN越多则召回率越低。精确率和召回率往往此消彼长:提高精确率通常会降低召回率,反之亦然。例如,在医疗诊断中,召回率很重要(不希望漏诊阳性病例),但过度追求召回率可能导致很多假阳性,降低精确率。实际应用中需要根据需求在P和R之间权衡。

F1分数: 为了综合考虑精确率和召回率,常使用F1-score作为评价指标。F1是精确率和召回率的调和平均数:F1 = 2 \cdot (P \times R)/(P + R)。F1分数在两者均衡时取得较高值,当精确率或召回率很低时F1也会偏低。因此F1适合用于不平衡分类问题的总体评估。除F1之外还有F2、F0.5等广义F指标,对精确率或召回率赋予不同权重,但F1是最常用的一种。

ROC和AUC: 在二分类中,当模型可以输出一个连续的置信度或概率时,我们可以通过调整阈值来平衡TP和FP率。ROC曲线(Receiver Operating Characteristic)反映了不同阈值下模型的性能:以真阳率(TPR = Recall)为纵轴,假阳率(FPR = FP/(FP+TN))为横轴,绘制出的曲线。ROC曲线越靠近左上角代表模型性能越好。一条45度对角线表示随机猜测的水平。AUC(Area Under the Curve)即ROC曲线下方面积,将模型分类能力量化为一个[0.5,1]之间的数值(随机分类器AUC约0.5,完美分类器AUC为1)。AUC具有阈值无关性和类别比例无关性,是评估分类模型(尤其是不平衡数据)性能的一个综合指标。

平均精度 (AP) 与 mAP: 在目标检测等需要综合考虑多个阈值或多个类别的任务中,常用平均精度(AP)和平均平均精度(mAP)指标。AP是Precision-Recall曲线下的面积,mAP则是对多个类别AP的平均,用于评估目标检测模型在所有类别上的总体性能。

回归指标: 对于回归问题(预测连续值),评估指标不同于分类。常见的有均方误差(MSE)、均方根误差(RMSE)、平均绝对误差(MAE)、R^2(判定系数)等。MSE是(\hat{y}-y)^2的平均,偏重于大误差(因为平方项),RMSE是MSE的平方根,与原始量纲一致。MAE是|\hat{y}-y|的平均,对异常值不如MSE敏感。R^2表示模型解释方差的比例,范围[0,1],越接近1说明模型对数据拟合越好。

交叉验证(Cross-Validation): 为了更稳健地评估模型性能并选择模型/超参数,常用交叉验证技巧。最常用的是K折交叉验证:将数据集随机分成K个不重叠子集,每次拿其中1折作为验证集,剩余K-1折作训练集,训练模型并评估在该验证集上的指标。重复K次(每折轮流做验证集),最终取K次评估结果的平均作为模型性能的估计。交叉验证充分利用了数据,减少了由于一次随机划分带来的偶然性,有助于更可靠地比较不同模型或参数设置。当数据量有限时,交叉验证尤其有用。不过交叉验证增加了计算开销(需要训练K次模型)。在模型训练成本较高或数据很大的情况下,简单的训练/验证拆分可能更实际。

留出法与自助法: 除K折CV外,还有一些其他验证方法。留出法(Hold-out)指直接划分出固定比例的数据作为验证/测试集,一次性评估。自助法(Bootstrap)是一种基于有放回采样的评估方法,从原始数据采样若干次构建训练集,未被采样到的数据作验证,通常用于数据量较小情况下估计模型偏差和方差。

选择评价指标和验证方法需视任务而定。例如,不平衡数据下Accuracy往往不足够,需要Precision/Recall/F1辅助;学术比赛中常以AUC或mAP作为排名指标;实际应用中可能根据业务代价选择特定指标(如误判成本)。通过合理的评估,我们才能客观比较模型、调优参数,并最终选择在测试集上表现最优的模型部署上线。

模型优化算法

在训练机器学习模型(尤其是神经网络)时,很多情况下需要通过优化算法最小化损失函数来求解模型参数。这一节介绍常见的优化方法,包括梯度下降及其各种改进算法。

梯度下降法(Gradient Descent): 梯度下降是利用目标函数的梯度信息进行优化的基本方法。在机器学习中,我们通常有一个损失函数 J(\theta)(如均方误差、交叉熵等)关于模型参数\theta,希望找到使J最小的\theta。

- 批量梯度下降(Batch GD) 每次利用全部训练样本计算梯度

\nabla_\theta J(\theta),然后按反方向更新参数:\theta := \theta - \alpha \nabla_\theta J(\theta),其中\alpha为学习率(step size)。批量GD每一步计算量大,但能利用全数据指引优化方向。 - 随机梯度下降(SGD)则在每次更新时只随机抽取一个样本(或一个小批mini-batch)计算近似梯度,参数更新频率高且更快迭代,但梯度噪声较大,损失曲线会在最优附近来回抖动而非平滑下降。

- 小批量梯度下降(Mini-batch GD)是折中方案,每次用一小块数据计算梯度,相比批量GD提高了效率,又比纯随机降低了波动。梯度下降的优点是实现简单且容易结合反向传播求导,但要选择合适的学习率:$\alpha$过大易震荡甚至发散,过小则收敛缓慢且可能陷入局部极小值。实践中通常需要试验或使用学习率调度策略(如指数衰减、余弦退火等)来调整$\alpha$。

动量法(Momentum): 动量方法为梯度下降引入惯性项,可以在一定程度上加速收敛并缓解局部震荡。具体做法是对梯度的指数滑动平均赋予“动量”概念。比如,引入变量$v$表示速度,更新规则:v := \beta v + \alpha \nabla_\theta J(\theta),\theta := \theta - v,其中\beta是动量因子(如0.9)。这样,当梯度方向持续相同时,速度$v$会累积,加快前进;若梯度方向来回变化,则之前的速度会部分抵消当前更新,减少震荡。动量法常用于深度学习优化中,它相当于在损失表面沿梯度方向增加了一种低通滤波效果,能帮助越过狭窄鞍点、降低振荡。

AdaGrad、RMSProp 等自适应学习率: 针对不同参数学习速率不同的问题,有一类方法会为每个参数维度设置各自的学习率并随训练动态调整。

- AdaGrad是早期提出的一种方法,它根据以往梯度累积的平方和来调整每一维的学习率:对于经历较大累计梯度的参数,学习率降低,反之增大。这对处理稀疏特征效果好,因为频繁出现的特征梯度累积大、学习率会降低,而罕见特征保持相对较大学习率。然而AdaGrad在后期可能由于累积梯度过多导致学习率过小而停止学习。

- RMSProp对AdaGrad进行了改进,引入了指数衰减的累积(类似动量思想)避免学习率单调降低:使用梯度平方的滑动平均来调整步长。

- Adam(Adaptive Moment Estimation)是目前深度学习中最常用的优化算法之一,它结合了动量和RMSProp的思想 (What is vLLM: A Guide to Quick Inference)。Adam为每个参数维护一阶矩(梯度的滑动平均)和二阶矩(梯度平方的滑动平均),并做偏差校正,然后以这两个估计值来动态调整学习率 (What is vLLM: A Guide to Quick Inference) (What is vLLM: A Guide to Quick Inference)。直观上,Adam在训练初期有较大步长,能够快速推进,在后期自动减小步长,实现稳健收敛。它对超参数(如初始学习率)的依赖相对较低,通常工作良好。因此大多数深度学习框架默认优化器都是Adam。需要注意的是,在某些设置下Adam可能收敛到略高的测试损失,比SGD略差泛化,这时也有人使用带有动量的SGD配合学习率衰减作为优化。

学习率调度(Learning Rate Schedule): 在训练过程中动态调整学习率有助于更好更快地收敛。常见策略包括逐步衰减(每过若干epoch将\alpha乘以一个小于1的因子)、指数衰减(\alpha按指数函数衰减)、余弦退火(学习率随epoch按照余弦曲线震荡式下降,有时配合热重启重新升高学习率)等。还有循环学习率策略让学习率在两个阈值间来回变化,使优化过程更可能跳出局部最优。选择合适的调度策略对训练深度模型特别重要。

早停(Early Stopping): 早停不属于优化算法本身,但常用来防止过拟合的技巧。在训练过程中监控验证集误差,当验证误差在若干迭代后不再降低甚至上升时,停止训练并恢复到误差最低点对应的模型。这等效于一种正则化手段,避免模型在训练集上训练太久而记住噪声。

综上,梯度下降及其各种改进方法是训练机器学习模型(特别是神经网络)的基石。实践中,一般会首选Adam等自适应优化器获取较快收敛,但在需要极致性能时,也可能改用调整精细的SGD结合动量和调度策略。对于凸优化问题(如线性模型的均方误差),简单的批量梯度下降足够找到全局最优,而对于深度神经网络这样的非凸问题,各种优化算法只能尽力找到一个较优的极小值解,并依赖于初始参数和调参技巧。因此,理解和选择恰当的优化方法,对成功训练模型至关重要。

特征工程与预处理

在传统机器学习中(深度学习兴起之前),特征工程常被认为是提升模型性能的最重要因素之一。即使在深度学习时代,良好的数据预处理和合理的特征表示依然是成功的基础。特征工程包含对原始数据的清洗、转换、编码和衍生,以便算法能够更有效地从中学习。

数据清洗: 原始数据常包含缺失值、异常值、重复数据等,需要在建模前清理。对于缺失值,常用处理方法包括删除含缺失值的样本(在数据量充足时)、用统计量填充(如均值/中位数填充数值型缺失,众数填充分类缺失)、或更复杂的插值和预测方法(如用模型预测缺失值)。对于异常值(outliers),可以通过统计手段检测(如超过均值±3倍标准差,或者IQR方法)并决定是否删除或修正,以免对模型训练造成不良影响。不过在某些情况下异常值本身可能是有价值的信息,需要具体问题具体分析。重复数据一般需要去重,以免模型训练受到重复样本的偏置影响。

特征缩放: 不同特征的取值范围可能相差很大,许多算法(如kNN、SVM、神经网络)对特征尺度敏感,因此需要对数值型特征进行缩放。常见方式有归一化(Normalization)和标准化(Standardization)。归一化通常指将值线性变换到[0,1]区间;标准化则将特征变换为均值0、方差1的分布(即减去均值再除以标准差)。标准化适用于大多数情况,使得梯度下降更快收敛、距离度量更有意义。对有偏分布的数据,也可以取对数、开方等非线性变换以缓解偏态。例如,对数变换可将长尾分布拉伸,使其更接近正态分布,减少极端值的影响。

类别编码: 对于离散的分类特征(Categorical Feature),学习算法无法直接处理文字标签,需要转为数值形式。最常见的是独热编码(One-Hot Encoding),为每个可能的类别创建一个独立二进制特征,样本属于该类别该特征取1,否则取0。这避免了人为赋值整数可能引入的大小关系错误。不过,当类别种类非常多时(如字典单词等),独热向量维度会很高,可以考虑目标编码(用该类别在训练集中目标均值代替)或嵌入编码(训练一个低维嵌入向量表示类别,在深度学习中常用)。对于有类别等级关系的特征(Ordinal Feature),可以用整数编码同时保留顺序关系,例如教育程度{小学, 初中, 高中, 大学}可编码为{1,2,3,4}。

特征构造: 有时原始特征不能充分表达有用信息,我们可以根据领域知识构造新特征。例如,在预测房价问题中,与其直接用房屋面积和房间数作为特征,不如创建“每平米房价”这样的特征可能更具预测力。又如将日期特征分解为年、月、日或星期,以捕捉季节性模式。对于模型表现欠佳的情况,人工增加特征交互项(如X_1 \times X_2)、多项式项(如X^2)等,交由线性模型学习,也是一种提升拟合能力的方法(对应于增加非线性)。特征构造通常依赖经验和试验,好的特征可以大幅提升模型效果。

维度降维: 当特征维度很高时(上百上千甚至更高),模型训练和理解都会变难,而且高维空间中样本变得非常稀疏,这被称为“维度灾难”。这时可以尝试降维。一种是特征选择:根据某些标准挑选出最重要的特征子集,如基于信息增益、卡方检验选择分类相关的特征,或用L1正则(Lasso)的稀疏性自动选择特征。另一种是特征提取:通过数学变换将原始高维特征投影到低维空间,同时尽可能保留信息。例如主成分分析(PCA)通过线性变换找到数据方差最大的方向作为新特征,将原始特征压缩成若干主成分;t-SNE、UMAP则是非线性降维方法,常用于数据可视化。降维可以去除冗余特征,降低模型复杂度和过拟合风险,提高训练速度。

数据增强: 严格来说属于训练技巧,但也可视为特征工程的一部分,特别是在计算机视觉领域。数据增强指对训练样本施加合理的随机变换生成新的样本,从而“增加”数据量、提高模型鲁棒性。例如图像分类中常用旋转、缩放、翻转、加噪声等手段来扩充训练集,使模型对这些变换不敏感。对于文本,可用同义替换、随机删除词等增强方法。数据增强在深度学习中广泛使用,它在不增加新标注成本的情况下帮助模型见到更多样化的情况,降低过拟合。

良好的特征工程需要对数据和任务有深入理解。对于传统机器学习算法,特征工程往往决定了模型性能上限;而在深度学习中,网络能够端到端学得特征表示,但前期的正确数据预处理和适当的数据增强依然非常重要。总之,垃圾进,垃圾出(Garbage In, Garbage Out),精心准备和处理数据是成功应用机器学习的前提。

正则化与模型泛化

正则化(Regularization)指在模型训练时对模型的复杂度进行约束,避免过拟合以提升泛化性能。前面提到的早停其实也是一种正则化策略。这里介绍几种常用的正则化技术,包括参数范数正则、.dropout、以及通过增加随机性或先验来提升泛化的方法。

L2正则化(岭回归): 在损失函数中加入参数权重的L2范数惩罚项是最常见的正则化方式之一。以线性回归为例,L2正则化的损失为:J(w) = \text{MSE}(w) + \lambda \sum_j w_j^2,其中$\lambda$是正则化强度超参数。L2惩罚促使权重尽可能小但不为零(趋向0),这等价于假设模型参数服从零均值的高斯先验。L2正则化会让模型偏向较简单、平滑的解,降低方差。岭回归(Ridge Regression)就是在线性回归中使用L2正则。对于神经网络,给所有权重添加L2正则化项(通常称为权重衰减)也是防止过拟合的常规手段。

L1正则化(Lasso): L1范数惩罚是权重绝对值之和:J(w) = \text{MSE}(w) + \lambda \sum_j |w_j|。与L2不同,L1正则化会促使一些权重精确为0,从而实现特征选择的效果。这就是套索回归(Lasso)的原理。在高维稀疏模型中,L1有用武之地。不过L1的优化不如L2简单(因为绝对值函数在0点不可导)。有时也会组合使用L1和L2正则,称为Elastic Net,兼具收缩权重和选择特征的作用。

Dropout: Dropout是一种针对神经网络的随机正则化技术。在每次训练迭代中,按照一定概率$p$随机将隐藏层神经元“丢弃”(设置为0,不参与本轮前向和反向计算)。例如$p=0.5$表示每个神经元有一半概率被暂时忽略。由于每次训练看到的是结构不同的子网络,这种方法迫使网络不要过分依赖某些局部特征,共享更鲁棒的组合特征 (ReAct Prompting | Prompt Engineering Guide )。测试时则使用完整网络但将各单元输出按$p$缩放(相当于取多个子网络预测的平均)。Dropout在大型神经网络上非常有效,显著减少过拟合,被视为深度学习里程碑式的正则化方法。不过在现代网络(如卷积网络、Transformer)中,有时Batch Normalization和更大数据集降低了对Dropout的需求,但在全连接层等情况下Dropout仍常被采用。

数据集扩充与扰动: 正如上一节所述,数据增强也是一种对抗过拟合的有效手段,相当于在输入空间加入扰动的正则化。此外,还可以在训练过程中对输入或隐藏层添加一些小的噪声(Gaussian noise等),类似于在模型学习过程中加入随机扰动,使模型对微小变化更稳健,这和Dropout思想一致。

模型集成: 虽然模型集成(下一节详述)本身不是针对单个模型的正则化,但可以看作一种在预测阶段的“正则化”:通过集成多个不同的模型,可以平滑掉单个模型的波动,从而降低泛化误差。Bagging(装袋)思想的随机森林就是通过对样本扰动训练多棵树并平均结果,变相地起到了正则化单棵树的作用。

归一化层: 在深度学习中,批归一化(Batch Normalization)层可以视为一种正则化。除了加速收敛外,BatchNorm因为在每个批次上对激活进行标准化,带来了随机噪声,有助于抑制过拟合。

模型复杂度控制: 在算法选择和模型架构上,也可进行正则。例如限制决策树的最大深度、叶子最小样本数,或限制神经网络的层数和每层单元数、使用较小的隐层维度等。此类措施直接控制模型容量,是避免模型过拟合的最直接方法之一。

总之,正则化的目的就是用稍高的偏差换取大幅降低的方差,获得更好的泛化能力。在实践中,需要根据任务和模型类型选择合适的正则化手段并调整其强度(如$\lambda$参数、Dropout概率等)。通常建议先从简单模型开始,逐步增加复杂度,同时逐步加强正则化,找到性能与泛化的最佳平衡点。

模型集成方法

模型集成(Ensemble)通过结合多个模型的预测来提升性能,被认为是“Kaggle制胜法宝”之一。集成方法利用不同模型的互补性,往往能获得比单一模型更好的泛化性能。下面介绍几种常用的集成策略:Bagging(装袋)、Boosting(提升)和Stacking(堆叠)。

Bagging(装袋) - 以随机森林为代表: Bagging的核心思想是通过对数据采样训练多个模型,然后对它们的预测取平均(回归)或投票(分类)。由于每个模型看到的训练集不同,它们彼此之间的误差不完全相关,平均后可以相互抵消部分误差从而降低方差。具体而言,Bagging通常通过自助法(Bootstrap)从原始数据有放回采样生成多个不同的训练子集(每个子集大小与原训练集相同,有放回采样导致约63.2%的样本出现,剩余是重复的),再在每个子集上训练一个基模型。预测时对所有模型结果取平均/多数票。Bagging适合于不稳定的基模型(对数据扰动敏感的模型,如决策树、神经网络)来减少方差。经典的随机森林(Random Forest)就是Bagging的改进版:它以决策树为基模型,除了对数据子采样外,还在每次节点划分时对特征进行子采样(每次只考虑所有特征的随机子集来选分裂),这样确保每棵树之间的差异性更大。随机森林在很多任务上表现优秀,因为单棵树有偏差、低深度下欠拟合,但森林通过集成显著降低了方差,同时树之间的随机性也让整体偏差略增加但可接受。Bagging的一大优势是容易并行化训练,因为每个模型相互独立。但Bagging无法降低偏差,如果单个模型有系统误差,简单平均并不能纠正它。

Boosting(提升) - 以AdaBoost、GBDT和XGBoost为代表: Boosting与Bagging不同在于它是串行地训练基模型,每个新模型都侧重于纠正前一组模型的错误,从而逐步提升整体性能。以AdaBoost(Adaptive Boosting)为例:初始时每个训练样本赋同等权重,训练一个弱分类器,然后提高那些被第一分类器分错样本的权重,再训练下一个分类器,使其更关注之前难分类的样本。如此迭代,最终将所有弱分类器按其性能加权组合。AdaBoost常用决策树桩(浅层树)作为弱分类器。梯度提升决策树(GBDT)是一种Boosting框架,用梯度下降思想逐步优化模型残差:第$m$次迭代训练的决策树拟合的是前$m-1$个模型的残差(即当前模型对目标的预测误差),通过不断加法累积树模型来逼近真实目标值。GBDT可用于回归和分类任务。XGBoost是GBDT的工程优化实现,采用第二阶泰勒展开的损失近似、正则化、Shrinkage等技巧,提升了训练速度和效果 (Bias Variance Tradeoff in Machine Learning) (Bias Variance Tradeoff in Machine Learning)。Boosting的优点是能够提高偏差(集成了很多弱学习器形成强学习器),因此往往性能极佳,不过也更易过拟合,需要通过限制迭代次数、树深度、正则化等控制模型复杂度。相比Bagging,Boosting模型的组成模型不独立,训练难以并行(但可在特定框架下做局部并行优化)。AdaBoost对异常值比较敏感(因为错误样本会被不断提高权重),GBDT通过优化残差缓解了这个问题。如今,XGBoost、LightGBM、CatBoost等Boosting实现已成为结构化数据比赛中的常胜模型。

Stacking(堆叠): Stacking通过训练一个元模型(meta-learner)来学习如何将若干基模型的预测组合起来。与简单平均不同,Stacking可以学习出最优的加权方式甚至非线性的组合。典型做法是:用初级训练集训练若干不同类型的基模型,然后在验证集上获得每个模型的预测输出,把这些输出作为新特征,验证集的真实标签作为新目标,训练一个次级模型(如线性回归、逻辑回归或小型神经网络)来拟合基模型的输出到真实目标的映射。最终预测时,基模型在测试集上输出,由次级模型整合得到最终结果。Stacking的优势是可融合风格各异的模型(例如将决策树、神经网络、SVM等长处结合),往往能取得比单一模型更好的效果。然而Stacking需要注意过拟合问题——一般在原始训练集上再做一次划分或使用交叉验证来产生基模型输出的训练集,以确保次级模型训练时的特征(基模型预测)是对未见数据的预测,从而保持独立性。此外,Stacking实现和调试相对复杂,训练时间也较长,因此多用于比赛和高要求场景,不如Bagging/Boosting那么普遍。

软/硬投票: 对于分类问题,还有一种简单的集成方法是不训练meta模型,而是直接对多个模型预测结果进行投票融合。硬投票指每个模型投一票,少数服从多数决定最终类别;软投票则平均各模型输出的概率分布,再取最大概率类别。软投票一般性能更好,因为充分利用了置信度信息。此方法适合于性能相近、独立误差的模型集。

模型集成的效用与代价: 集成通过引入模型多样性和决策融合,几乎总能带来更好的性能,尤其在单模型很难做得更好的情况下。不过集成也增加了复杂度:模型训练和推理时间、内存占用都会变大,缺少单一模型的可解释性,部署也更复杂(需要同时维护多个模型)。因此在工业应用中,需要权衡精度提升和资源消耗。有时,一个经过仔细正则化和调参的单模型已经足够且更易部署;而在追求极致性能的竞赛或关键任务中,集成则非常常见。

总之,模型集成是提升机器学习效果的强有力手段。对于开发者,掌握Bagging和Boosting等原理有助于理解诸如随机森林、XGBoost等强力算法的由来,也为进一步在工作中尝试集成多模型提供思路。

强化学习简介

强化学习(Reinforcement Learning, RL)是一类特殊的机器学习方法,关注智能体如何在环境中通过试错获取最优行为策略。RL在机器人控制、游戏智能、资源调度等领域有重要应用。本节将简要介绍强化学习的基本概念和典型算法框架,如值函数、策略梯度,以及Q学习和策略梯度方法的核心思想。

基本框架: 一个典型的强化学习问题由智能体(Agent)和环境(Environment)构成。两者通过连续的时序交互形成闭环:在离散时间步t,智能体观察到环境的状态s_t,基于当前策略\pi选择一个动作a_t;环境接收到动作后转移到新状态s_{t+1},并给智能体一个即时奖励(Reward) r_t,奖励可以是正(鼓励)或负(惩罚)。智能体的目标是通过与环境的反复交互,学习一套策略\pi(a|s),使得累积奖励(通常对未来奖励设折扣因子\gamma,求和\sum \gamma^t r_t)最大化 (ReAct Prompting | Prompt Engineering Guide )。这一过程通常假定满足马尔可夫决策过程(MDP):即下一状态和奖励只取决于当前状态和动作,与过去历史无关,环境转移具有Markov性质。

强化学习框架:上图示意了强化学习的循环过程。智能体(Agent)观察环境状态,依据策略选择动作(Action),作用于环境(Environment)。环境根据动作反馈新的状态和奖励给智能体。智能体以累积到的奖励作为优化目标不断调整策略。通过这样的反馈环,智能体逐渐学会在各种状态下采取最优动作。

值函数和Bellman方程: 为了衡量某个状态或状态-动作对的好坏,RL中引入值函数概念。状态值函数V^\pi(s)定义为智能体在状态s下按照策略\pi行事所期望的累积奖励:V^\pi(s) = \mathbb{E}*\pi[\sum*{t=0}^\infty \gamma^t r_t | s_0 = s]。类似地,动作值函数Q^\pi(s,a)是在状态s采取动作a后,后续按照\pi演化的累积奖励期望。最优策略对应最优值函数V^*(s)和Q^*(s,a),它们满足著名的Bellman最优方程:Q^*(s,a) = \mathbb{E}[r + \gamma \max_{a'} Q^*(s',a') | s,a],V^*(s) = \max_a Q^*(s,a)。Bellman方程刻画了最优值函数的自一致性质,也是许多RL算法的基础。

Q学习(Q-Learning): Q学习是一种无模型(model-free)的值迭代算法,直接学习最优动作值函数Q^*(s,a)的近似。它基于上面的Bellman方程进行迭代更新:Q(s_t,a_t) := Q(s_t,a_t) + \alpha [r_t + \gamma \max_{a'}Q(s_{t+1},a') - Q(s_t,a_t)],其中\alpha是学习率。这被称为时序差分(TD)更新——用当前的经验对Q估计进行更新,TD误差为方括号内的部分。Q学习通过不断采样状态-动作-奖励-新状态四元组来更新Q表,最终收敛到Q^*。实际实现时,智能体需要在探索(exploration)和利用(exploitation)之间权衡,如采用\epsilon-贪心策略:以概率\epsilon随机探索动作,以概率1-\epsilon选择当前$Q$值最大的动作利用所学知识。Q学习不需要环境转移模型,只通过试错逐步逼近最优值函数,对各种任务都通用。缺点是如果状态空间和动作空间很大,直接维护$Q$表格会很困难,需要借助函数逼近(如深度Q网络DQN使用神经网络近似Q(s,a))。尽管如此,Q学习奠定了强化学习的重要基石,是解决许多问题的起点。

策略梯度(Policy Gradient): 与值函数方法不同,策略梯度直接对策略进行建模和优化。通常假设一个带参数\theta的随机策略\pi_\theta(a|s)(如软max策略或高斯策略),定义目标J(\theta)为策略的预期累积奖励。策略梯度法通过梯度上升调整参数:\theta := \theta + \alpha \nabla_\theta J(\theta)。根据策略梯度定理,梯度\nabla_\theta J(\theta)可以表示为\mathbb{E}*\pi[\nabla*\theta \log \pi_\theta(a|s) \cdot G(s,a)],其中G(s,a)是策略执行下从(s,a)开始的回报。简单的实现是REINFORCE算法:采样一条轨迹,把每个时间步得到的折扣回报G_t当作G(s_t,a_t)的无偏估计,则梯度\nabla_\theta J \approx \sum_t \nabla_\theta \log \pi_\theta(a_t|s_t) \cdot G_t。用这种采样梯度更新\theta。策略梯度方法的优点是可以直接输出概率策略,方便处理连续动作空间等情形,也没有值方法那样的偏差(是无偏梯度)。但其梯度估计方差较大,收敛慢。常用改进包括Actor-Critic架构:同时训练一个策略(actor)和一个值函数critic,用critic估计的优势函数A(s,a)=Q(s,a)-V(s)替代G_t,降低方差从而提高稳定性。

探索-利用困境: 在强化学习中,智能体既要利用当前经验选择看似最优的动作获取高奖励,又要探索未尝试的动作和状态以发现潜在更优的策略。这两者是矛盾的:过度利用会使智能体陷入次优策略,过度探索又会浪费时间。解决该困境是RL的重要课题。常用的方法除了\epsilon-贪心,还有UCB上置信界用于多臂老虎机问题、软策略在每一步按Boltzmann分布选动作、或者更高级的探索策略如基于贝叶斯或启发式的方法。深度强化学习中也有加入熵正则化鼓励策略分布的熵(随机性),以保持探索。

模型与不确定性: 有些RL算法假设可以访问环境的动力学模型(state transition and reward functions),可基于模型进行规划(如动态规划方法);而无模型方法直接从交互采样学习。另一个维度,不确定性和延迟奖励也是RL难点之一,例如信用分配问题:长期回报由多步动作共同导致,如何判断哪个动作贡献更大很困难,这正是值函数和策略梯度所要解决的。

强化学习相比监督学习更加灵活强大,但也更具挑战:样本效率低、探索难度大、训练过程不稳定等。一些经典成果包括:TD-Gammon用强化学习下棋取得接近顶尖水平,AlphaGo系列结合蒙特卡洛树搜索和深度强化学习击败围棋冠军,OpenAI Five在Dota2复杂团队游戏中自学达到职业水准等。这些成功归功于强大的函数逼近(深度网络)和大规模采样,但也展示了RL在实际复杂任务中的潜力。

对于初学者,理解网格世界等简单环境中的Q学习、策略梯度运作方式,是进入强化学习领域的第一步。更深入的主题包括:分层强化学习、策略优化算法(PPO、DQN改进等)、多智能体强化学习、以及将强化学习与监督学习、大模型结合的新进展(如强化学习用于人类反馈RLHF、大模型在决策问题中的应用)等。

深度学习与框架

深度学习(Deep Learning)是近年来机器学习最引人注目的领域,它基于多层神经网络,在语音识别、计算机视觉、自然语言处理等方面取得了突破性成果。本章节首先介绍深度神经网络的基本结构(包括CNN、RNN、Transformer等)及其应用场景,然后比较主流深度学习框架(如PyTorch、TensorFlow和PaddlePaddle)的特点与使用场景。

深度神经网络基础

人工神经网络简介: 人工神经网络(ANN)受生物神经系统启发,由大量神经元(Neuron)节点及连接构成。最简单的神经网络是感知机(Perceptron),它接收多个输入,通过加权求和并加上偏置,然后经由一个激活函数输出结果。如果激活函数是阶跃函数,单层感知机可用于线性可分的二分类问题。将感知机拓展为多层结构就得到多层前馈神经网络,也称多层感知机(MLP)或深度神经网络(DNN)。典型的DNN由输入层(接受原始特征)、一个或多个隐藏层(每层包含若干神经元,接收前一层输出)、和输出层组成。层与层之间通常是全连接的。每个神经元计算如下:h = f(w \cdot x + b),其中$w$是权重向量,x是上一层输入向量,b为偏置,f为非线性激活函数。

激活函数: 为了使神经网络具有非线性表示能力,隐藏层都会使用非线性激活函数。经典的激活函数包括:Sigmoid(\sigma(x)=1/(1+e^{-x}))将输出压缩在(0,1)之间,早期常用于二分类输出层或隐藏层;Tanh(双曲正切)将值映射到(-1,1),输出零均值,在Sigmoid基础上改进;ReLU(修正线性单元,f(x)=\max(0,x))是现代深度网络最常用的激活,它计算简单且缓解了梯度消失问题。ReLU在x>0时梯度为1,在x<0时梯度为0,相当于对神经元输出进行稀疏化(一部分单元输出0)。还有ReLU的变种如Leaky ReLU(负半轴给一个小斜率)避免“死亡ReLU”、ELU、SELU等。选择合适的激活函数有助于训练收敛和性能表现,当前ReLU/其变种和偶尔的Swish/Mish较为常见。

前向传播与反向传播: 神经网络通过前向传播计算输出,通过反向传播算法来学习权重。前向传播即按层计算输出,最终得到损失L。反向传播根据链式法则计算损失对每层参数的梯度,从输出层逐层往回传播误差。具体来说,对输出层先计算\delta = \partial L/\partial z(z是该层线性变换输出),然后对每层的权重W、偏置b有梯度:\partial L/\partial W = \text{输出}^{\text{上层}} \times \delta,\partial L/\partial \text{输出}^{\text{上层}} = W \times \delta,继续往前。这种高效的逐层计算让我们能用梯度下降训练数十层深的网络。值得注意的是,在非常深的网络中,梯度在反向传播时可能逐渐消失或爆炸,这需要通过合适的初始化、激活函数选择、正则化手段(如BatchNorm)等缓解。

卷积神经网络(CNN)

CNN简介与卷积操作: 卷积神经网络(Convolutional Neural Network, CNN)是专门用于处理格状数据(如图像、语音)的神经网络。它引入卷积层来替代全连接层,从而充分利用数据的局部相关性和平移不变性。以图像为例,卷积层由若干卷积核(滤波器)组成,每个卷积核是一个权重矩阵(如3times3大小),在图像上滑动与区域进行点积运算,提取出局部特征图。卷积运算有两个重要特性:局部连接(每个神经元只与上一层输入的局部区域相连)和参数共享(同一卷积核在不同空间位置复用)。这使得CNN相较于全连接网络有大幅减少的参数,同时可以学习到有意义的局部模式(如边缘、纹理)并在全图通用。除了卷积层,CNN通常还包含池化层(Pooling)来对特征进行降采样,例如最大池化取局部窗口内最大值,平均池化取平均值,池化能压缩数据尺寸、降低计算量并增加不变性。

典型的CNN架构通常呈现层级结构:输入层是原始图像像素;后面交替堆叠卷积层(+非线性激活)和池化层,逐步从低级特征到高级特征;最后接若干全连接层整合特征用于输出分类。早期经典网络如LeNet-5(用于手写数字识别)和AlexNet(赢得ImageNet 2012比赛,将CNN推向流行)都遵循这个模式。现代CNN如VGGNet增加了深度、ResNet引入了残差连接(skip connection)解决深层梯度消失问题,使得网络能够训练到数百层之深。CNN在图像分类、目标检测、图像分割等任务上取得了卓越效果,因为卷积操作非常契合图像数据的结构,能够高效提取空间特征。值得一提的是,CNN不仅应用在视觉,也扩展到一维序列数据(如1D卷积用于时间序列和文本特征提取)。

CNN的直观理解: 可以将卷积核理解为模式检测器——例如早期层的卷积核学习到边缘检测、纹理模式,后期层的卷积核则组合这些简单模式形成对复杂图形(如人脸、物体部件)的响应。这种分层结构使CNN具有很强的特征学习能力,且对输入的平移、轻微变形具有鲁棒性,因为卷积核滑动捕捉模式,不管它出现在哪个位置都能检测到。正因如此,CNN成为图像处理领域的主力模型。

循环神经网络(RNN)

RNN基本原理: 循环神经网络(Recurrent Neural Network, RNN)擅长处理序列数据(如时间序列、文本语句),因为它在网络中引入了循环连接,允许信息在序列各位置之间传播。一个基本RNN可以被看做在时间维度展开的网络:给定序列输入x_1, x_2, ..., x_T,RNN在每个时间步t都有隐藏状态h_t,它由当前输入和前一时刻的隐藏状态共同决定:h_t = f(W_{xh} x_t + W_{hh} h_{t-1} + b_h),同时输出y_t = W_{hy} h_t + b_y。这样,隐藏状态h_t起到了“记忆”的作用,携带了先前序列的信息,影响后续的输出。这种结构天然适合处理变长输入输出,例如根据之前词预测下一个词,或对整个句子分类等。

序列学习的难点:梯度消失和爆炸:RNN可以通过BPTT(Backpropagation Through Time)来训练,即将RNN在时间展开成T层的深层网络,然后对参数累计梯度。但是由于长时间展开,RNN的梯度容易出现消失或爆炸的问题——这与深度网络类似甚至更严重,因为每一步的递归相当于网络深度加1。当序列很长(几十上百步以上),早期信息对后面输出的影响经过多次状态转移会指数式减弱,训练时对应的梯度几乎消失,导致RNN很难捕获长距离的依赖关系。这在实践中导致基本RNN难以记忆较早的序列信息。而梯度爆炸则可以通过梯度裁剪(clip)等手段控制。

LSTM和GRU: 为了解决长程依赖学习问题,长短期记忆网络(LSTM)和门控循环单元(GRU)被提出。LSTM引入了“门控”机制:包括输入门、遗忘门、输出门,对信息在细胞状态(cell state)中的流动进行控制 (ReAct Prompting | Prompt Engineering Guide )。LSTM通过设计特殊的状态传递方程,可以在很长序列中保留梯度,相比普通RNN更能记忆长距离信息。GRU是LSTM的简化版本,将输入门和遗忘门合并成更新门,结构更简单但性能相近。这些门控RNN已经成为处理自然语言序列、时间序列的标准工具,在2015年前后RNN+LSTM一度是NLP的主流架构(如序列标注、机器翻译采用双向LSTM+注意力机制)。不过LSTM模型在时间步上无法并行(需要一步步计算),对超长序列仍有困难。近年来,Transformer的出现取代了RNN在很多场景的统治,但RNN在某些需要严格序列顺序的信息(如语言模型)上仍有应用,而且概念上帮助我们理解序列依赖的建模。

双向RNN和编码器-解码器: 对于需要利用全局上下文的任务,双向RNN会从序列正反两个方向各有一个RNN提取特征,然后将前向和后向隐藏状态拼接用于输出,这样每个时刻的表示既包含前文也包含后文信息(适用于序列整体预测,如语音识别、序列标注)。Encoder-Decoder结构是RNN在序列到序列学习中的拓展:编码器RNN将输入序列压缩成一个上下文向量,解码器RNN以此向量为初始隐藏状态,生成输出序列。这种架构成功用于机器翻译,但单一上下文向量限制了性能,于是引入注意力机制(下一节Transformer详述)来改善。

总的来说,循环神经网络提供了一种自然的方式来处理顺序数据中的依赖关系。LSTM/GRU的门控设计有效延长了可记忆范围,使RNN在一系列序列任务中取得成功。然而,其串行性的劣势在大数据训练下逐渐显现,因此在需要高速并行训练(例如海量语料的语言模型预训练)时,现在多被Transformer所取代。但理解RNN对于掌握深度学习发展脉络和序列建模思想仍然重要。

Transformer 架构

自注意力机制: Transformer网络引入的核心是自注意力(Self-Attention)机制,它让序列中的每个位置对序列其他位置的信息进行加权汇总,从而捕获全局依赖。具体来说,对于输入序列的表示{x_1,...,x_T},Transformer为每个位置i计算查询(Query)q_i、键(Key)k_j和值(Value)v_j向量(它们是x通过可学习矩阵投影得到)。位置i对位置$j$的信息权重通过q_i与k_j的点积得到注意力分数,通常用softmax归一化形成注意力权重\alpha_{ij},然后计算位置i的输出为序列中所有位置的值的加权和:z_i = \sum_{j} \alpha_{ij} v_j。这一操作允许网络灵活地从序列各元素获取关联信息,而不局限于局部邻域。

Transformer结构: Transformer由堆叠的多层注意力模块和前馈网络组成,没有循环也没有卷积。一个标准Transformer编码器层包含两部分:首先是多头自注意力(Multi-Head Self-Attention),它并行执行多组注意力计算(不同头关注不同特征子空间),然后将各头结果拼接再线性变换;接下来是位置前馈网络,即两个全连接层的非线性映射(常用ReLU)。此外,还有Residual残差连接和Layer Normalization使训练稳定。Transformer解码器在自注意力之外还插入了编码器-解码器注意力,使解码时能够关注输入序列的相关部分。Transformer提出于论文《Attention is All You Need》(2017),最初应用于机器翻译,在速度和效果上都超过了当时的RNN+注意力模型。

Transformer的优点: Transformer完全抛弃了循环,通过自注意力实现并行建模全局依赖。对于长序列,它的单次计算复杂度是O(T^2)(注意力计算对序列长度二次方增长),但比RNN的时序依赖O(T)更适合GPU并行,因此在海量数据训练下更有效。此外,自注意力可以直接看到远处的信息,不存在RNN那种长程梯度难传递的问题,因此Transformer更易于学习长期关系。Transformer也具有模块化的特点,可以堆叠很多层得到非常深的网络,而ResNet式的残差让训练深层Transformer成为可能。

Transformer在各领域的应用: 最初Transformer用于机器翻译等NLP任务,如今自注意力已经成为NLP任务的默认模型结构。基于Transformer的预训练语言模型(如BERT、GPT系列)取得了极大成功,使NLP发生范式转变。在计算机视觉领域,也开始出现纯Transformer结构的模型(ViT等)替代CNN提取图像特征,取得与卷积网络相当甚至更优的效果,尤其在大数据预训练情况下Transformer表现突出。音频和时间序列处理也有Transformer的身影。可以说,Transformer以其强大的建模能力和并行计算优势,统一了序列建模的方法,并跨越文本、图像、语音等多种模态,被认为是深度学习近年最重要的发明之一。

注意力的挑战和改进: 虽然Transformer威力强大,但自注意力计算在长序列上$O(T^2)$的复杂度会成为瓶颈。为此有大量研究提出高效注意力机制(如Linformer、Reformer、Sparse Attention等)降低计算量,使Transformer能处理更长序列。另一个挑战是Transformer缺少对序列位置的内在建模,因此需要加入位置编码(Positional Encoding)或相对位置编码让模型感知顺序。此外,大模型训练需要大量数据和算力,训练稳定性、内存占用等也在不断改进(如Norm的改进,Fully Sharded数据并行等)。

总的来说,Transformer已经成为现代深度学习的重要基石。通过自注意力,它实现了对序列数据前所未有的建模灵活性,并扩展到了视觉、跨模态等更广阔领域。理解Transformer对于掌握当今前沿AI模型(尤其大语言模型)的工作原理至关重要。

主流深度学习框架比较

深度学习的兴起也伴随着开源框架的蓬勃发展。目前最主流的框架包括PyTorch、TensorFlow(及其高阶接口Keras)、以及国内发展迅速的PaddlePaddle(飞桨)。它们各有特点和适用场景,下面进行简要比较。

PyTorch: 由Facebook(现Meta)开发的PyTorch以动态计算图和良好的Pythonic接口著称。它最初在研究界迅速流行,因为使用方式与NumPy等很接近,调试方便,支持即时运行每一步操作(eager execution),代码风格简洁明确。PyTorch的动态图机制允许模型结构根据输入改变,灵活性高,非常利于研究人员开发新模型和调试。目前PyTorch也具备成熟的训练优化(如分布式训练、TorchScript静态图导出等),在工业界的部署支持也越来越完善。2019年后,PyTorch逐渐超越TensorFlow成为深度学习开发者的首选框架。

TensorFlow: 来自Google的TensorFlow曾经是深度学习框架的霸主。它早期(1.x版本)采用静态计算图模式,用户需要先定义计算图,再在会话中执行,这种方式利于优化和部署但编码调试不直观。TensorFlow在工业界应用广泛,提供了丰富的工具(TensorBoard可视化、TensorFlow Serving部署等),并且支持多种语言调用。在研究领域,由于使用门槛较高,一度热度下滑。Google在TensorFlow 2.x推行了Eager Execution和与Keras接口的整合,使开发体验更贴近PyTorch。此外,TensorFlow有庞大的生态,特别在生产环境上依然有优势,比如TPU硬件支持。总体来说,TensorFlow适合需要端到端产品化、跨语言支持的场景,而在自由探索和小型实验上目前稍逊于PyTorch的人气。

Keras: Keras最初是独立的高级框架,后来成为TensorFlow官方高级API。Keras以极简易用著称,它提供了封装良好的模型、层、训练流程接口,用户可以很快搭建起标准网络并训练。在TensorFlow 2中,tf.keras作为默认接口,同时提供足够自定义的灵活性。对于入门者,Keras的顺序模型(Sequential)和函数式API能快速上手构建模型;对于有经验者,Keras也允许自定义层、模型和训练循环。Keras的不足是过于高级封装可能限制了一些底层操作的控制,不过TensorFlow允许在Keras下嵌入低级操作以获得需要的灵活性。

PaddlePaddle: 飞桨是百度开源的深度学习框架,也是国内首个自主研发的大规模深度学习平台。早期飞桨与TensorFlow类似,采用静态图编程,后来也引入了动态图模式。飞桨在国内有政策和产业支持,提供了丰富的预训练模型和工具组件(如PaddleDetection、PaddleOCR等针对应用的套件),对于中文 NLP 和垂直行业优化较多。相比PyTorch/TensorFlow,飞桨的国际社区和成熟度稍弱一些,但在国内文档、社区、企业支持方面有优势。对于国内企业,飞桨能够更好地对接本土资源和服务(如国产硬件、政府支持项目)。

其他框架: 另有一些专用或新兴框架,如MXNet(亚马逊开源,曾用于GlounCV/NLP等库,现在影响力降低)、MindSpore(华为开源,主要在国内推广)、JAX(Google推出的函数式自动微分库,在科研尤其ML前沿研究中兴起)等。还有如TorchScript、ONNX等用于模型部署跨框架工具。

使用场景与选型: 总的来说,如果专注学术研究、算法创新或个人项目,PyTorch当前是第一选择,其用户社区活跃、第三方库(如HuggingFace Transformers)支持度高。若要构建大规模系统、跨平台部署或用TPU训练等,TensorFlow依然是可靠的方案,尤其TF 2.x结合Keras也提供了接近PyTorch的开发体验。PaddlePaddle在国内应用和中文支持上具有独特价值,若项目希望依托国内生态或需要飞桨已有的行业模型套件,可以考虑使用。值得一提的是,这些框架的核心思路类似,熟练掌握一个,再学习其他也比较容易。真实应用中,往往选择主要看团队已有代码基础、硬件适配和具体需求。例如训练阶段用PyTorch快速迭代模型,然后将模型导出为ONNX格式,在推理服务器上用TensorRT加速部署。

综上,深度学习框架的发展使得开发AI模型的效率大大提高。对于学习者,选择一个框架深入实践即可,但也应了解其他框架的特色和生态。在不断演进的AI工程中,灵活运用框架,加速实验和落地,是重要的工程技能。

领域应用拓展

掌握了机器学习和深度学习的基础后,我们可以将这些技术应用到不同领域中,解决各类实际问题。本章节将深入介绍机器学习在几个重要应用场景中的实践,包括自然语言处理(NLP)、计算机视觉(CV),以及新兴的检索增强生成(RAG)技术、基于大模型的智能Agent系统,最后讨论多模态数据的处理方法。这些内容将帮助读者将通用的机器学习方法迁移运用到具体领域,并了解各领域中的特殊技术和挑战。

自然语言处理(NLP)应用

自然语言处理是机器学习的重要领域,涉及文本数据的分析和生成。NLP任务多种多样,包括文本分类、序列标注、机器翻译、文本生成等。在这些任务中,机器学习方法(尤其是深度学习)已成为主流手段。下面介绍NLP中的若干典型任务及对应的方法技巧。

文本分类: 文本分类是将一段文字归入预定义类别的任务,如垃圾短信识别、情感分析(正面/负面评价)、新闻主题分类等。传统方法包括提取文本特征(如基于词频的TF-IDF向量)然后训练分类器(如朴素贝叶斯、SVM等)。深度学习方法则以分布式表示(嵌入)为基础,将单词映射为向量,再用卷积网络(如TextCNN)或者循环网络(如Bi-LSTM)对句子编码,最后接一个全连接或softmax输出类别。在中文等语言上,要处理分词或者直接以字符为单位。近年来,基于预训练模型如BERT的方案成为主流:先用大规模语料无监督训练BERT获取通用语言表示,然后微调一个分类头实现具体分类任务。使用预训练语言模型大幅提升了各类文本分类的精度。对开发者而言,实现文本分类常用开源工具/库(如HuggingFace Transformers)快速获得强大的预训练模型并fine-tune。

命名实体识别(NER): NER是序列标注任务的一种,要从文本中找出并分类特定的实体(如人名、地名、机构名等)。这是典型的序列预测问题,可以用条件随机场(CRF)等传统统计模型或RNN+CRF深度模型来解决。常见方法是使用双向LSTM提取每个字/词的上下文特征,然后通过CRF层做全局判别,输出每个位置的标签(B-机构、I-机构、O等标签表示开始、内部或非实体)。也有用CNN或Transformer替代RNN的。预训练模型同样适用于NER,通过fine-tune BERT在标注数据上,可取得当前最佳性能。NER需要考虑标签方案(BIO标注等)和错配问题,是NLP应用中较为成熟的一项。

文本生成与语言模型: 文本生成包含很多任务,如机器翻译(将一种语言翻译成另一种语言)、文本摘要(生成短摘要)、对话系统(生成回复)以及通用的语言模型续写文本等。经典机器翻译一度由RNN Encoder-Decoder+注意力模型主导,如Google神经翻译系统使用了8层Encoder-Decoder的LSTM。但现在Transformer彻底改变了这一领域,基于Transformer的序列到序列模型成为翻译、摘要的标配。例如Transformer架构的GPT模型作为纯语言模型,可以根据已给前文续写自然语言文本;而像BART、T5这样预训练的序列到序列Transformer可以用来做摘要或对话。语言模型是指估计句子概率或生成句子的模型,比如GPT系列通过在海量文本上预测下一个词训练,成为强大的生成模型。文本生成任务的评估较为困难,翻译有BLEU分数等,摘要有ROUGE,每种任务都有特定评价标准。此外,为避免模型生成不连贯或无意义文本,可能需要引入约束解码、惩罚重复等技巧。近年来的大规模预训练模型(如GPT-3、ChatGPT)能进行惊人的文本生成,对NLP应用产生巨大影响。对于开发者来说,善用这些大模型(通过API或开源checkpoint)往往比从零训练更实际。

词嵌入(Word Embedding)与预训练模型: 词嵌入是NLP里程碑式的概念。Word2Vec算法(包括CBOW和Skip-gram)在2013年提出,让每个单词对应一个训练得到的向量,成功捕获了词语的语义相似度(如“国王-男人+女人≈王后”)。此后又有GloVe等全局共现矩阵因素分解的方法获得词向量。这些静态词嵌入为NLP任务提供了初始化特征表示,在深度学习模型未普及时非常流行。现在,词嵌入的思想被扩展到预训练语言模型:它们不再给出单个词的定向向量,而是能根据上下文生成每个词的表示(上下文嵌入),解决了一词多义等问题。比如BERT会为同一个词在不同句子中产生不同的向量表示。预训练模型通常在巨量无标签语料上通过自监督任务(如遮盖词预测、下句预测)训练,获得语言理解能力,然后微调(fine-tune)在下游特定任务。预训练-微调范式已成为NLP默认方案,大幅降低了各任务对标注数据的需求,提高了性能。因此,在NLP应用中,往往首选一个合适的预训练模型(BERT系列偏重理解,GPT系列偏重生成,T5可用于生成和理解)进行迁移学习。对于具体任务如分类、问答、对话等,都可以通过构造适当输入输出格式来利用这些预训练模型完成(即所谓Prompt或prefix微调等)。

其他NLP任务: 还有许多NLP任务值得提及:如问答系统(分为机器阅读理解MRC和开放域问答等)、信息检索(通常和NLP结合比如通过embedding检索语义相关文本)、对话系统(任务型对话和开放域聊天,ChatGPT的对话属于后者,结合了预训练与RLHF)、语义相似度判断、知识图谱相关的实体关系抽取等。它们通常也可以归类为分类、序列标注或生成任务,并用类似的模型处理。近年来多任务统一的模型(如T5, GPT的Prompt调优)使得一个模型可以应对多种NLP任务,展现出NLP任务之间的联系。

总结来说,NLP任务繁多,但方法上已经因为预训练模型而趋于统一范式。对于开发者,理解文本数据的特征表示方法(词袋、词嵌入、预训练embedding)和常见的模型结构(双向RNN+CRF、Transformer Encoder、Encoder-Decoder等)很关键。在实际应用NLP时,还需注意文本的清洗与规范化(去除噪音符号、拼写校正等),标签体系(如命名实体种类),以及评测方法的选择。通过不断在任务中积累经验,可以更好地运用机器学习技术解决语言问题。

计算机视觉(CV)应用

计算机视觉涉及图像和视频的数据分析,包括图像分类、目标检测、图像分割、人脸识别、OCR等众多任务。深度学习,特别是卷积神经网络的兴起,使CV领域取得重大突破。本节将介绍几个CV中的典型应用任务以及相应的主流方法。

图像分类: 图像分类是CV最基本的任务之一,即判断给定图像属于哪一类别(例如猫或狗)。早期传统方法需要人工设计特征(如SIFT、HOG)然后训练分类器(如SVM)。如今,卷积神经网络几乎完全取代了传统方案。自AlexNet在ImageNet比赛上获胜后,CV分类模型不断进步,出现了VGG、GoogLeNet(Inception系列)、ResNet等经典网络。这些模型通过加深层数或引入新模块不断提高准确率。训练一个高性能分类模型通常需要大规模带标签的数据(ImageNet有1000类、120万训练图像)。对于一般开发者,常用做法是迁移学习:利用ImageNet上预训练的CNN模型,在自己数据集上微调。可以冻结前几层卷积只训练后几层,或者全模型fine-tune,视数据规模而定。这样即使数据量不大也能获得很强的分类效果。当前分类任务中准确率最高的是一些巨型模型(如NoisyStudent, ViT-Huge等)在ImageNet上可以超过90%Top-1准确率。实际应用中应考虑模型大小与速度,根据需求选择MobileNet这类轻量模型或ResNet这类高精度模型。评价分类性能除了准确率,也看Top-5准确率、多标签分类要用适当的指标(如mAP)。

目标检测: 目标检测需要找出图像中所有目标的位置(以边界框表示)及其类别。检测比分类复杂得多,因为图像中可能有多个对象且大小不一。深度学习检测算法主要分为两大类:两阶段检测器和一阶段检测器。两阶段的典型代表是R-CNN系列:首先用Selective Search等方法生成候选框,再用CNN分类候选框内容;后来有Fast R-CNN、Faster R-CNN逐步优化(Faster R-CNN用区域提议网络RPN替代Selective Search),成为高精度的检测框架。一阶段检测器直接在图像上回归边界框并预测类别,如YOLO(You Only Look Once)系列、SSD(Single Shot MultiBox Detector)、RetinaNet等。它们往往在速度上更有优势。YOLOv1开创性地将检测作为一个回归问题端到端解决,此后YOLOv3、v4、v5等版本持续改进,成为工业界常用的实时检测算法。最新的如YOLOv7仍在刷新速度与准确平衡记录。衡量检测算法的指标通常是mAP(平均精度)在各种IOU阈值下的平均,有时也考虑推理速度FPS。除了通用目标检测,特定场景还有行人检测、人脸检测等专门算法,但现在一般通用框架加特定数据也能完成。开发者在做检测任务时,可以使用开源实现(如Detectron2、MMDetection、YOLO框架)并在自有数据上fine-tune模型。需要注意标注质量和正负样本的不平衡处理。

图像分割: 图像分割进一步提升了检测的精度,要对图像每个像素进行分类,得到精细的目标轮廓。语义分割要求给每个像素标注所属类别(不区分实例个体),实例分割则要区分不同实例(可看做检测+分割)。经典的分割网络有FCN(全卷积网络),它将CNN的最后全连接层改成卷积,使输出为和输入等尺寸的密集预测图。随后U-Net(一种编码器-解码器结构,中间有特征逐步下采样再逐步上采样,跳跃连接融合高低层信息)在医学图像分割中大获成功,也被广泛应用。DeepLab系列引入了空洞卷积和条件随机场后处理,提升了分割细节。实例分割通常采用Mask R-CNN:在Faster R-CNN检测框基础上增加一个并行的分割分支,为每个检测框输出高质量mask。还有Panoptic分割(结合语义+实例)。分割模型评价指标通常用IOU或其均值(mIOU)、像素准确率等。分割需要像素级标注,成本高,但在自动驾驶、医疗影像等重要场景有巨大价值。开发实践中,常用pretrain的骨干网络(如ResNet, Swin Transformer)做语义分割微调,如果追求实例分割则采用Mask R-CNN等实例分割框架。

光学字符识别(OCR): OCR任务将图像中的文字内容识别为文本,涉及CV和NLP的结合。OCR通常分为文本检测和文本识别两步:先在图像中定位出文字区域(检测),再对这些区域进行字符识别。常用的检测算法有基于分割的(如PSENet、PANet)和基于回归的(如CTPN)等,识别部分则可以用卷积或卷积+RNN的序列模型,将图片序列预测为字符序列。比如经典的CRNN框架:卷积提取特征序列,RNN+CTC解码输出文本。近年也有端到端的Transformer OCR模型。评估OCR通常看字符准确率或编辑距离。OCR系统开发涉及图像预处理(去噪、二值化)、版面分析(表格、公式的处理)等工程问题。幸运的是,现在有非常多开源的OCR引擎(如Tesseract、PaddleOCR、Tencent OCR等)可以直接使用,很多还能支持多语言和竖排文本。对于开发者而言,如果OCR不是核心问题,通常选择集成现有OCR服务或工具即可,否则也可以针对特定场景训练自有模型(例如训练一个卷积识别模型用于车牌识别等)。

其他CV任务: 视觉领域还有非常丰富的任务和应用,比如人脸识别(需要在人脸验证和识别中达到高精度,FaceNet等深度模型通过学习人脸embedding和度量学习实现)、姿态估计(检测人体关键点)、行为识别(通过视频帧序列判断行为类别)、图像生成(GAN生成以Pix2Pix、CycleGAN、StyleGAN著称,以及最近流行的扩散模型如Stable Diffusion实现文本生成图像)等。每个方向都有其专门的模型和评测标准(如FID评价生成质量)。还有跨领域的如医学影像诊断,也是图像分类/分割在医学数据集上的应用。

综上,计算机视觉已被深度学习革命性改变,各种任务的大部分最佳方法都是基于深度神经网络。对开发者来说,CV项目中数据准备和标注往往是耗时的重要环节,要针对具体任务制定标注策略。然后选取合适的模型架构和预训练权重进行fine-tune。如果数据有限,考虑数据增强(翻转、尺度、颜色抖动等对图像来说很重要)。训练过程中监控验证集mAP或IOU等,避免过拟合。还需注意模型推理的效率,尤其在嵌入式或移动端场景可能要剪枝或用轻量模型。通过不断实战,逐步掌握CV各子领域的技巧,才能灵活运用机器学习解决视觉问题。

检索增强生成(RAG)

检索增强生成(Retrieval-Augmented Generation, RAG)是一种结合信息检索和文本生成的大模型应用新范式。其核心思想是:利用外部知识库来增强语言模型的生成,使生成内容更加准确和具备实时性。这对于大语言模型(LLM)特别重要,因为LLM参数固化了训练时的知识,对于训练后出现的新知识无法直接获取,而且LLM可能会编造(“幻觉”)不真实的细节。通过将检索模块嵌入生成流程,可以有效提高模型回答的真实性和时效性。

RAG基本机制: RAG通常包括两个主要部分:检索(Retrieval)和生成(Generation) (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。首先,系统建立一个知识库或文档库,比如维基百科文章、公司内部文档、产品手册等。可以对这些文档预先进行索引,方式通常是将文档分段并计算嵌入向量,构建高效的向量索引(例如使用FAISS或其他向量数据库)。当用户提出一个查询(如一个复杂问题),RAG系统会先根据查询从知识库中检索出相关的文档片段(通常通过向量匹配找到与查询embedding相似的文本片段) (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain) (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。接着,将检索到的文本片段与原始问题一起送入语言模型,作为提示上下文,让模型参考这些资料来生成回答 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。由于模型在生成时“看到了”相关资料片段,它能够提取事实信息,从而生成内容时减少凭空捏造。这种方法也被称作“Open-book QA”(对比于闭卷,模型可以翻书找答案)。

实现方式: 目前RAG的实现有多种。可以将检索-生成显式分开实现:先用一个独立的检索模块获取top-k篇文档,然后把问题+文档作为prompt输入GPT等模型生成答案。另外也有将两者融合训练的,如RAG模型(Facebook 2020年提出的RAG模型)把BERT做的检索和BART做的生成组合成端到端架构,但实践中分开实现更灵活易调试。构建RAG应用有一些关键要点:

1)知识库准备:需要将文档进行预处理拆分(段落、句子等粒度),计算embedding索引。embedding通常用预训练的句向量模型或多模态embedding模型。

2)检索:根据用户query计算其embedding,在索引中搜索最近邻,选出若干相关文本(比如取前3段)。

3)组装提示:通常会设计一个Prompt模板,将用户问题和检索到的文本整合,如:“根据以下资料回答问题:\n资料1: ...\n资料2: ...\n问题: ...\n答案:”。

4)生成:调用大语言模型(如GPT-3/4,或本地的开源模型如Llama2)生成答案。这一步模型需要能够利用给定资料,如果模型是指令微调过的,会较好遵循输入中“根据资料回答”的指示。一些实现会特别在Prompt里强调“不在资料中则回答不知道”,以减少幻觉。

5)后处理:可以对生成的答案做一些校验,如果需要可将答案中的事实与资料对比验证一致性。

RAG的应用场景: RAG非常适合构建问答系统或聊天机器人,特别是在需要准确参考知识的企业场景。例如客户支持聊天,RAG可以连接产品文档库确保回答准确;搜索引擎问答,背后以wiki等为知识源;医疗问答,以医学文献为资料等。RAG也用于检索增强对话,如微软的BioGPT就是在对话中引入文献检索。OpenAI的插件功能也支持网络检索然后再回答,实质就是RAG思想。除了问答,RAG思想还能用于内容生成需要依据资料的场景,比如根据数据库记录生成报告等。

实现工具: 构建RAG应用需要将检索与LLM对接,目前已有一些开源工具简化流程。LangChain就是流行的框架,提供了针对RAG的组件,如文档加载、分块、embedding计算、向量存储、retriever接口,以及chain封装,将“检索+LLM”流程串起来。开发者只需配置好文档路径和LLM,使用LangChain的RetrievalQA链即可快速得到一个问答系统 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。另一项目LlamaIndex(GPT Index)也提供类似能力,更专注于文档索引管理和检索。向量数据库方面,有商业的Pinecone、Milvus,开源的FAISS等来存储和搜索embedding。利用这些工具,可以较方便地搭建起RAG系统。

RAG的挑战: 尽管RAG很有前景,但也有一些挑战需要注意。检索模块的效果取决于embedding模型的质量,如果embedding没能把相关文本找回来,生成部分也无从发挥。同时,LLM对提示的依赖很大,如果提示设计不佳可能忽视资料或乱编。此外,将外部资料融入LLM会受限于上下文窗口大小,如果相关内容很多超过模型上下文容量,就需要采取分页、多轮检索等策略。还有及时性问题,知识库需要定期更新才能覆盖最新信息。RAG系统还应考虑引用来源:有时希望输出答案时附上引用哪个资料(比如Bing Chat回答会附网页链接),这需要在Prompt或模型设计上显式要求。

总的来说,检索增强生成是结合信息检索和生成模型的有效范式,为构建可查证、知识丰富的AI系统提供了实用架构 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain) (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。对于开发者,它提供了一条让大模型“连通”外部知识的途径,而不必完全依赖模型参数存储所有信息。在实际应用RAG时,多花精力准备高质量知识库和embedding,会显著提升最终系统的表现。

Agent 类系统中的机器学习

近期出现了一类引人注目的应用框架,被称为“大模型驱动的 Agent(代理)系统”。这类系统如ReAct、AutoGPT等,尝试让AI自主规划和执行一系列步骤去完成复杂任务。在这些系统中,机器学习(特别是大型语言模型)扮演核心角色,用于决策、推理和操作。这里我们讨论两个典型:ReAct框架和AutoGPT,并分析机器学习在其中的作用。

ReAct 框架: ReAct(Reason + Act)是2022年提出的一种让语言模型同时进行推理和行动的策略 (ReAct Prompting | Prompt Engineering Guide ) (ReAct Prompting | Prompt Engineering Guide )。传统的Prompt通常让模型直接输出答案,而ReAct的Prompt引导模型交替地产生“思考(Thought)”和“行动(Act)”。思考是模型的中间推理过程,行动则可以是调用外部工具(如搜索引擎、计算器)或者给出最终回答。通过在few-shot示例中演示这种格式,模型学会在复杂问题上,先输出一系列思考步骤,每一步可能包括对问题的分析或提出要查询的信息,然后输出一个动作比如Search[关键词]去查询资料 (ReAct Prompting | Prompt Engineering Guide )。环境(例如一个搜索API)执行该动作并返回结果(Observation),模型将Observation纳入下一轮思考。如此循环,直到模型认为可以得到答案时,输出Finish[答案]。 (ReAct Prompting | Prompt Engineering Guide )这种方式让模型能够自主分解问题并使用工具,比如对付一个复杂问答,模型可以通过ReAct prompt先思考问题拆解,再决定检索维基百科,然后根据检索结果推理出最终答案 (ReAct Prompting | Prompt Engineering Guide )。实验表明,ReAct可以提升LLM在知识问答和决策任务上的表现,因为它结合了模型自己的推理能力与外部环境交互。

在ReAct中,ML模型(例如GPT-3)本身就是核心决策者。它的推理(Thought)依赖于预训练学到的知识和推理能力,行动的决策则体现了模型对何时需要工具的判断。可以说,ReAct是一种特别的Prompt技巧,赋予静态的语言模型一种“脚本执行”能力,让模型一边思考一边和环境交互 (ReAct Prompting | Prompt Engineering Guide )。这并不涉及模型参数更新,而是完全通过提示工程实现。因此,机器学习的角色主要体现在语言模型强大的few-shot学习能力和隐式推理能力。如果没有像GPT-4这样强的模型,ReAct框架难以奏效。另外,为了训练或运行ReAct agent,常需要收集一些示例演示正确的Thought-Act格式,或者通过强化学习从人类反馈(RLHF)来进一步对模型行为微调,使其更合理。总的来说,ReAct展示了通过巧妙设计输入,现有大模型可以在不修改权重的情况下完成复杂连贯的推理+操作过程。

AutoGPT: AutoGPT是2023年初在社区兴起的一个开源实验,它定位为一个“自主的AI代理”,能够给定目标后自动分解任务、调用工具、产生结果 (AutoGPT - Wikipedia)。AutoGPT背后也依赖OpenAI的GPT-4或GPT-3.5 API,但它构建了一个循环系统:AutoGPT有一个任务列表,模型会检查目标,如果任务未完成就生成计划和下一步行动,执行后再评估结果、更新任务,直到目标完成或停下来 (AutoGPT - Wikipedia)。AutoGPT还集成了诸如网络搜索、文件读写等能力,使其可以自主在互联网获取信息、写入/读取本地文件作为长时记忆等 (What is AutoGPT? What You Need to Know - TechTarget) (AutoGPT - Wikipedia)。通俗地说,AutoGPT尝试把GPT变成一个不需要人提示每一步的智能体。开发者Torant描述AutoGPT为一种可自动运行的AI代理,它通过将总目标拆解为子任务并自主迭代来实现目标 (AutoGPT - Wikipedia)。AutoGPT是一个复杂的系统工程,但核心依赖的还是大语言模型的规划和生成能力。例如,为了决定下一步行动,AutoGPT给GPT一个prompt,里面包含当前的目标、已完成的步骤、剩余任务等,要求模型输出下一步方案和理由,然后自动执行之 (ReAct Prompting | Prompt Engineering Guide )。AutoGPT还引入了一些“反馈循环”,比如如果模型输出不合适的步骤,系统可以在prompt中加入“思考的Critic”角色要求模型自我修正。

机器学习(LLM)在AutoGPT中承担了“大脑”的角色。AutoGPT本身没有新的学习算法,而是围绕预训练的大模型构建逻辑,把模型作为决策和生成引擎使用 (AutoGPT - Wikipedia)。目前这种Agent的性能和可靠性还有限,经常会进入无效循环或做出糟糕决定,需要人介入。这暴露出当前语言模型在缺少人类提示监督时,完全自主工作仍有困难。但AutoGPT之类的尝试,为AI自动化工作流提供了范例。如果配合强化学习训练,让模型在模拟环境中学会更好地规划和执行,未来可能出现更强大的自主Agent。

ML在Agent系统中的角色和挑战: 总结来说,在ReAct、AutoGPT这类Agent系统中,大模型(及其背后的ML训练)提供了通用的推理和语言理解能力,这是Agent智能的基础。相比传统强化学习的Agent需要从零学策略,LLM-Agent拥有强大先验知识,能处理开放任务和灵活对话。然而,这些模型也有明显限制:无实时学习机制(需要离线大规模训练才能提升)、缺少可靠性(可能胡乱规划)、成本高(每步调用模型消耗算力)。为克服这些,未来方向包括将符号规划与LLM结合、增加模型记忆机制、使用人反馈微调Agent行为等。Reinforcement Learning可以在其中发挥作用,比如用RL训练模型更好地使用工具、正确停止等。可以预见,Agent系统将是机器学习和符号AI结合的前沿领域,大模型是催化剂但还需要更多算法改进来实现真正自主智能体。

对开发者而言,当前这些Agent框架多是实验性质,可以尝试用它们自动完成一些任务,但结果需要监控。理解Prompt设计对于控制Agent行为非常重要。Agent类系统还涉及调用搜索、执行代码等模块的集成,实现上要注意这些模块的接口稳定。总之,Agent系统展示了让机器学习模型不再局限于回答问题,而是主动决策执行的可能,预示着AI应用从单轮对话向连续自治方向的演进。

多模态数据处理方法

多模态(Multimodal)机器学习旨在让模型同时处理和理解多种类型的数据(如图像+文本,音频+文本,视频+音频+文本等)。人类感知世界是多模态融合的,因此让AI融合多模态信息能够提升对复杂场景的理解和生成能力。本节介绍几种主要的多模态组合及其处理方法,包括图像-文本、音频/视频-文本融合等。

图像 + 文本: 图像与自然语言的结合是热门的多模态方向,任务包括图像字幕生成(Image Captioning)、视觉问答(Visual Question Answering, VQA)、跨模态检索、文本引导的图像生成等。典型做法是设计一个融合模型:使用CNN提取图像特征,用RNN或Transformer处理文本/问题,然后通过注意力机制或其他融合层将两者信息结合。

- 图像描述(Captioning):传统结构为CNN编码图像得到向量表示,作为初始状态喂给LSTM生成描述句子。后来Attention机制应用于此,让生成文字时能动态关注图像不同区域(Show, Attend and Tell模型)。现在Transformer-based的caption模型或者采用CLIP这种跨模态预训练模型进行微调,都取得很好效果。评价caption常用BLEU、METEOR等类似机器翻译的指标。

- 视觉问答(VQA):模型输入一个图像和一个问题(自然语言),输出问题答案。可以看作一个三输入模型:图像特征、问题特征和答案分类/生成。早期有各种设计,如将图像CNN特征和问题LSTM特征通过元素积融合然后分类答案。后来流行使用双流注意力(bi-modal attention):比如使用Transformer同时编码图像region特征和问题词,让注意力负责找图文对齐关系。VQA有两类:封闭式(答案有限,比如选择题)和开放式(输出自由文本)。评价用准确率或开放式结果的近似匹配。

- 跨模态检索:给图找相关文本或给文本找相关图(如在图片库中根据描述搜图)。典型技术是学习共同的嵌入空间:如CLIP模型通过对海量图文对进行对比学习,让图像和对应描述的embedding距离很近,不对应的距离远 (ReAct Prompting | Prompt Engineering Guide )。这样检索时可以把查询(图或文本)映射到embedding,再在embedding空间最近邻搜索另一模态。CLIP被证明有强大zero-shot能力,可直接用于文本提示分类图像,也启发了很多应用(如稳健的跨模态对齐)。

- 图像生成(基于文本):将文本模态转换为图像模态。近年来扩散模型如Stable Diffusion、DALL-E引领了文本生成图像风潮。这些模型通常由一段文本嵌入引导高维图像空间的迭代生成。背后也需要跨模态对齐:比如CLIP文本编码指导生成过程。一些GAN也做过类似工作(AttnGAN等)。文本-to-Image模型评估难以量化,多以案例展示和用户偏好为准。

音频/语音 + 文本: 常见的多模态任务包括语音识别(ASR)、语音合成(TTS)、语音对话(结合ASR和NLP)、以及视频字幕(需要用语音+视觉识别对话)。严格来说,语音和文本是一种模态与符号的双向转换关系。

- 自动语音识别:输入语音音频,输出文本转录。传统ASR分声学模型、语言模型、发音词典,现在end-to-end常用Listen Attend Spell或CTC模型,将语音特征(如Mel频谱)送入类似Encoder-Decoder的结构直接解码文字。近期由Transformer或RNNT(RNN-Transducer)等架构取得SOTA。大型语音模型如OpenAI Whisper能处理多语种且抗噪强。

- 语音合成(TTS):给定文本生成语音波形。近年TTS的质量飞跃,基于神经网络的Tacotron系列用Encoder-Decoder预测梅尔谱图,再用神经声码器(WaveNet、WaveGlow等)将谱图生成波形。现在TTS逼真度高,可控制音色韵律,也出现零样本的情感语音克隆模型。

- 语音对话系统:是ASR+NLP理解+对话管理+NLG+TTS的流水线,需要多模态协同才能最终完成语音交互。现在有端到端试图直接映射语音听懂再回语音,但一般还是模块化。

视频 + 文本 + 音频: 视频是综合模态,包括视觉帧序列、音频轨道,往往还可以提取其中的语音转文本。多模态视频分析任务如视频描述(给一段视频生成字幕)、视频问答、动作识别等,需要融合图像帧信息和语音语义。一个例子是电影内容分析,可结合视觉场景、对白文本、背景音乐情绪多方面来理解剧情。模型上通常需要单独提取每种模态特征(图像序列用3D CNN或时序模型,语音用RNN/Transformer,文本用语言模型),然后融合。Transformer很适合多模态融合,如果把不同模态特征看作序列的一部分输入,它可以学到各模态之间的关联。Meta的VideoCLIP等模型也尝试预训练跨视频和文本embedding,使模型能检索和生成跨模态内容。

多模态融合技术要点: 关键在于对齐(Alignment)和融合(Fusion)。对齐指不同模态之间的关系,例如图像中的哪个区域对应文本某些词。这可以显式通过Attention做(如VQA时question单词对图像region注意力),也可以隐式通过联合表示空间。融合则指如何将不同来源的信息合在一起用于决策,简单如特征拼接、加权相加,复杂如训练一个特定的融合网络或者使用Transformer交叉注意力。另一挑战是模态不完备:有时某模态缺失或不可靠,需要模型能灵活应对,例如视频无声音也能部分理解。模型训练往往需要多模态配对数据,获取标注成本更高,一些无监督或弱监督学习(如利用同步的信号作为监督)很有用。Google的ALIGN、OpenAI的CLIP是成功的跨模态大模型案例,它们利用互联网的海量图文对,实现了跨模态表示学习的突破。

多模态与大模型: 越来越多迹象表明,多模态是下一代AI模型的重要方向。OpenAI的GPT-4已具备图像理解能力(可输入图像),称为“视觉语言模型”。一些研究如Flamingo、Minotaur等探索视觉-文本统一的Transformer,其Few-shot能力很强。Meta的ImageBind一次性学了6种模态(图像、文本、音频、深度、热感、IMU数据)统一embedding,被称为基础多模态模型。多模态大模型可以实现丰富的任务,例如给图像写详解、看图对话,甚至控制机械设备(绑定状态传感)。对于开发者,这意味着未来AI系统可以更容易地处理多模态输入输出,开发应用时要有多模态思维,比如一个应用不仅有文字界面,也可以加语音、图像交互。

实践中的工具: 有一些工具库专注多模态应用,如Facebook的MMF(Multimodal Framework),HuggingFace的Transformers也集成了一些多模态模型(VisionEncoderDecoderModel、CLIPModel等)。另外OpenCV之类在CV,Librosa之类在音频处理也是必备。多模态数据处理有时需要对不同数据同步,对时间轴对齐,这在实现时要考虑。

综上,多模态机器学习旨在打破单一模态限制,让模型获取更全面的信息。它在感知、交互、内容生成等方面都有广阔前景。随着硬件和算法进步,多模态模型的训练和部署将越来越普及。对于工程实践,初期可先组合已有单模态模型实现多模态功能(如ASR+NLP+TTS管线),进阶可尝试使用预训练多模态模型(如CLIP)增强系统能力,最终也可根据需要训练定制的多模态模型。多模态AI将逐步接近人类对世界的综合理解。

技术框架与工程落地

机器学习系统在实际落地过程中,需要借助各种工程框架和工具来加速开发和优化性能。本章节讨论几项近期实用的技术:如何结合LangChain框架快速开发RAG应用,如何进行大模型微调(LoRA、PEFT、QLoRA 等)以定制模型,模型推理加速手段,以及在多模态系统中用到的WebRTC、FFmpeg等组件。这些内容更偏向工程实践,能够帮助开发者把机器学习模型有效地融入应用。

LangChain 与 RAG 应用

LangChain是近年来流行的用于构建基于大语言模型应用的开发框架。它提供了一系列抽象和工具,方便开发者将LLM和其它计算模块(如检索、计算工具、记忆等)链接起来,组成复杂的应用流程 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。前面在RAG部分介绍的检索增强生成就是LangChain的主打场景之一。下面具体看看LangChain的作用和用法。

LangChain核心概念: LangChain的名字来源于 “Language Model Chain”。其核心思想是把Prompt(提示)和LLM调用封装为可以组合的链条。LangChain主要提供了几个模块:

- Prompt模板(PromptTemplate):用于动态构建提示词,把用户输入或中间结果插入模板字符串中。例如一个QA模板:“根据以下知识回答问题。\n{context}\n问题: {question}\n回答:”。

- 模型接口(LLM, ChatModel等):统一对接各种大语言模型,不管是OpenAI API、本地模型还是聊天模型。使用LangChain,可以用统一的方法调GPT-3、GPT-4,或本地的HF Hub模型。

- 记忆(Memory):用于对话场景,存储对话历史并在新提示中加入历史记录。LangChain内置如短期记忆(只记最近几轮)、长对话摘要记忆等,方便实现连续对话。

- 工具(Tools):封装可以被LLM调用的外部功能,如搜索引擎、数据库查询、Python执行等等。在LangChain中,可以定义一些工具及其调用接口。当模型需要用这些工具时,可以通过特殊格式的输出触发调用。LangChain可以解析模型输出决定调用哪个工具,并将工具返回结果再交给模型。这与前面ReAct思想类似。LangChain甚至提供现成的ReAct Agent实现,让模型学会使用工具 (ReAct Prompting | Prompt Engineering Guide )。

- 链(Chain):这是LangChain的核心抽象,把多个步骤(可能包括Prompt -> LLM -> 工具 -> LLM等)组合成一个流程。常见的Chain如RetrievalQA:先用问题查询retriever获取文档,然后把文档和问题送入LLM输出答案 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。Chain可以嵌套或串联,实现复杂逻辑。LangChain也提供ConversationalRetrievalChain专门用于聊天QA。

- 索引(Indexes):主要用于文档检索相关,LangChain可以帮助将大量文档切分、向量化,并存入向量数据库,然后提供统一的Retriever接口进行检索。

用LangChain构建RAG应用: 一般流程如下:1)使用LangChain的DocumentLoader加载原始文档(可读文件夹下所有txt/pdf等);2)用TextSplitter将长文档分段;3)调用Embeddings接口将每段文本转换成向量(LangChain内置一些embedding模型或可对接OpenAI embedding API等);4)将向量存入VectorStore(如FAISS、本地Chroma或外部Pinecone等),获取一个retriever对象 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。这部分通常在离线Indexing阶段完成 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。然后,在应用运行时,对于用户的提问,调用retriever相关方法,如retriever.get_relevant_documents(query),得到若干相关文本 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。接着设置好Prompt模板将文档插入和问题一起,最后调用LLM模型完成回答生成。LangChain的RetrievalQAChain封装了这些步骤,开发者只需配置embedding模型、向量存储、LLM和模板即可直接使用 (Build a Retrieval Augmented Generation (RAG) App: Part 1 | ️ LangChain)。LangChain还允许自定义Chain,如果要在回答前后加一些额外逻辑,比如先让模型格式化地提取答案出处引用等,都可以写自己的Chain。

LangChain的优势: 它封装好了很多样板化的代码和细节处理,比如自动处理token长度超限(太长文档自动refine或map-reduce)、对接各种模型和数据源等,让开发者不用每次从零写一堆调用代码。LangChain抽象出的“Chain”也鼓励将LLM调用当作一个函数模块,这有助于调试和单元测试。LangChain生态也很活跃,针对常见应用(聊天、Agent等)有丰富的示例和现成组件。例如SQLDatabaseChain可以让GPT自动用自然语言查询SQL数据库;SerpAPI工具让模型通过LangChain访问实时的Google搜索结果。总之,LangChain相当于提供了构建“LLM应用流水线”的框架,让开发者更关注应用逻辑。

注意事项: 虽然LangChain强大,但也要小心过度依赖。调试LangChain应用可能会遇到模型输出格式不符预期、工具调用多带来的状态管理等问题,需要仔细设计Prompt和Chain。LangChain默认将大量信息打印日志,这对于分析Agent行为有用。还有LangChain应用的稳定性和响应速度,要考虑底层模型接口的延迟和错误情况(如OpenAI API超时)。在生产中,要做好缓存或降级策略。LangChain不断更新,有时接口会改变,所以版本锁定也重要。

总而言之,LangChain是构建RAG等复杂LLM应用的利器,通过高度抽象帮助开发者快速实现知识问答、对话机器人、自动化Agent等系统。这体现了软件工程思想与机器学习结合的新趋势:模型本身强大,但需要合理 orchestrator 来发挥作用,而LangChain正提供了这样的 orchestrator 平台。

大模型微调策略

随着预训练大模型(尤其是大语言模型)的兴起,如何在有限资源和数据下对这些模型进行微调(Fine-tune),以适应特定任务或领域,成为一个重要课题。传统微调需要对模型全部参数进行训练更新,但对于数十亿参数的模型,这在存储和算力上成本巨大。为此,出现了一系列参数高效微调(PEFT, Parameter-Efficient Fine-Tuning)方法,如LoRA、Adapter、Prefix-Tuning等。下面重点介绍当前流行的LoRA及其延伸QLoRA,并概述这些技术的原理和应用。

LoRA(Low-Rank Adaptation): (LoRA vs. QLoRA)LoRA由微软提出,是一种高效微调大模型的方法 (Low Rank Adaptation: A Technical deep dive)。LoRA的核心思想是:冻结预训练模型原有权重,不对其直接修改,而是为每个需要微调的权重矩阵增设一个低秩分解的增量矩阵,以此来适应新任务 (LoRA vs. QLoRA)。具体实现上,对于模型中的某个权重矩阵W_0(尺寸d \times k),LoRA引入两个小矩阵$$A$(尺寸$d \times r$$)和B(r \times k),使得实际权重为:W = W_0 + \Delta W,其中\Delta W = A B,且r \ll \min(d,k) (LoRA vs. QLoRA)。在微调过程中,W_0保持不变,只训练A和B的参数 (LoRA vs. QLoRA)。由于A和B的尺寸远小于W_0,微调的参数总量大幅减少。训练完毕后,推理时将\Delta W加到W_0上即可,无需改变模型结构。

LoRA的效果来自这样一个假设:模型为新任务所需的权重改变量\Delta W是一个低秩矩阵 (Low Rank Adaptation: A Technical deep dive) (Low Rank Adaptation: A Technical deep dive)。实际实验表明,即使$r$取很小的值(如8、16),LoRA在诸多任务上微调效果接近全参数微调。LoRA的优点:

1)参数效率:只需训练2r大小的矩阵,而原矩阵可能巨大,例如对于尺寸4096x4096的权重,r=16则参数减少到原来的0.4%;

2)存储效率:可以为不同任务保存不同的\Delta W,因为原始W_0固定,共享一份,当需要切换任务只需加载对应小矩阵,这样一个大模型可以快速切换多个定制任务而无需每次存储完整模型;

3)训练更快:参数少导致内存消耗和计算少,也降低过拟合风险,因为本质上在给定基底上学习小偏移,有正则作用 (LoRA vs. QLoRA)。

LoRA已被广泛应用于大语言模型微调,如Stanford的Alpaca(基于LLaMA模型)就是用LoRA在52k指令数据上微调出一个指令跟随模型。LoRA的实现也很简易,在PyTorch里可通过低秩矩阵插入等方式;HuggingFace的PEFT库提供了开箱即用的LoRA接口。使用LoRA时需要选择应用哪些层的权重,一般对Transformer里的注意力投影矩阵用LoRA效果较好。LoRA的超参主要是秩r和缩放系数\alpha(控制\Delta W影响大小),需要在验证集上调优。由于训练参数少,有时可以尝试大一些学习率。

PEFT其他方法: 除LoRA外,还有Adapter和Prefix Tuning等PEFT技术。Adapter是在每层网络插入一个小的瓶颈全连接层组,只训练这些Adapter层参数;Prefix-tuning则是在模型输入序列前面添加可训练的虚拟token embedding序列(prefix),模型参数不变,只训练前缀向量。它们也能有效微调但原理不同。总体来说,LoRA因为实现简便、对预训练模型侵入小(不改变模型结构,只在计算时加了点)、效果好而特别受欢迎。

QLoRA: QLoRA是近期(2023年中)提出的方法,将LoRA与模型量化结合,使得在单张GPU上微调百亿甚至千亿参数模型成为可能 (Making LLMs even more accessible with bitsandbytes, 4-bit ...) (Making LLMs even more accessible with bitsandbytes, 4-bit ...)。QLoRA的做法:首先把预训练模型权重量化为4比特(尤其使用一种名为NF4的新型4-bit格式 (LoRA vs. QLoRA)),这样模型内存占用减少4-8倍,同时也降低计算精度稍许影响。然后在此量化模型上应用LoRA微调,只调整LoRA引入的参数而不破坏量化的主权重。由于微调期间主模型固定(量化了也不变),4-bit近似不会被梯度一步步放大误差,因此可以稳定训练 (QLoRA and 4-bit Quantization - Chris McCormick)。QLoRA让一个65B参数的LLaMA模型微调所需GPU内存从数百GB降到了<48GB,可以在单机进行 (Making LLMs even more accessible with bitsandbytes, 4-bit ...)。HuggingFace团队用QLoRA成功在多任务指令数据上微调出140亿和30亿参数的新模型(如LLaMA-Adapter),性能媲美原模型甚至超过。QLoRA的意义在于极大降低了微调大模型的硬件门槛,使得小团队也可以定制大模型能力 (Making LLMs even more accessible with bitsandbytes, 4-bit ...)。

使用QLoRA要注意选择合适的量化方案(最好是有针对性优化如NF4,普通4-bit int可能效果差些),另外训练时最好采用逐渐冻结embedding和最底层参数的方法以稳定训练。一些框架如bitsandbytes提供了简单接口直接加载4-bit模型和执行LoRA训练。QLoRA展示的思路是,将前沿的模型压缩技术与PEFT结合,进一步提升资源效率。

其他微调策略: 还有全参数微调(已不现实大模型场景)、微调部分层(如仅微调最后几层或某些层,这样参数更新少但依然需要存储整个模型副本)、知识蒸馏(借助小模型学习大模型行为,可以看作微调的替代方法)等。如果目标是在小设备上运行,可能还需结合量化感知微调或蒸馏来获得小模型。PEFT方法有时可以组合使用,如LoRA+Prefix一起,不冲突的。

应用场景: 微调大模型在企业落地时很有价值,因为很多开源基座模型(如BERT, GPT-NeoX, LLaMA等)可以拿来,根据自有数据微调后,就变成一个专属模型,效果比通用模型更贴合需求。比如行业客服问答,微调让模型记住专业术语和特定问答;生成式任务,微调对风格、结构进行定制。利用PEFT,不需要庞大GPU集群就能做到。一些社区项目如LoRA训练的Alpaca、Vicuna模型,已经证明小数据小计算下获得惊人效果。特别是LoRA微调通常只需几小时就可见效,非常高效。

总之,LoRA和QLoRA等技术代表了在预训练大模型时代的一种高效迁移学习范式:冻大脑,换小插件 (LoRA vs. QLoRA),用很小的参数代价让模型掌握新技能。掌握这些技术,开发者可以以较低成本不断试验和迭代模型能力,而不必每次承担训练全模型的高昂代价。

模型推理加速

部署机器学习模型(尤其是深度学习模型)到生产环境,需要考虑推理(Inference)的性能优化。特别是大模型和实时性要求高的服务,推理加速技术能够大幅降低延迟和成本。这里介绍几种重要的推理加速手段和工具:vLLM引擎、ONNX和ONNX Runtime,以及Triton推理服务器等。

vLLM 高吞吐量推理引擎: vLLM是2023年出现的一个专门针对大语言模型(LLM)推理的开源引擎,由UC Berkeley等开发 (What is vLLM: A Guide to Quick Inference - Hyperstack) (What is vLLM: A Guide to Quick Inference)。传统的模型推理框架(如Transformers库)在多请求并发生成长文本时,GPU资源利用率并不高,因为生成属于自回归,需要按序一批批进行,GPU常空闲等待 (What is vLLM: A Guide to Quick Inference)。vLLM通过创新的连续批处理(Continuous Batching)和分页注意力(Paged Attention)技术,提高GPU利用率 (What is vLLM: A Guide to Quick Inference) (What is vLLM: A Guide to Quick Inference)。Continuous Batching指将不同请求的推理批次动态合并,比如当一些请求已完成前面token生成但别的请求还在生成,vLLM可以把它们拼一起,让GPU同时处理更多token (What is vLLM: A Guide to Quick Inference) (What is vLLM: A Guide to Quick Inference)。这样减少了等待,提高了吞吐和降低了延迟。Paged Attention则是将注意力的KV缓存存储换成分页管理,类似操作系统的虚拟内存思想,可以支持更长上下文且节省显存 (What is vLLM: A Guide to Quick Inference) (What is vLLM: A Guide to Quick Inference)。据报道,vLLM相比标准Transformers推理,吞吐提升可达数倍 (What is vLLM: A Guide to Quick Inference)。vLLM特别适合搭建LLM服务,支持多用户并发对话。许多应用如聊天机器人希望用一张GPU服务尽可能多并发用户,vLLM的优化对这种场景非常有利 (What is vLLM: A Guide to Quick Inference)。目前vLLM支持Transformer类LLM的推理并兼容HuggingFace模型格式,易于集成。

ONNX 和 ONNX Runtime: ONNX(Open Neural Network Exchange)是业界通用的神经网络模型交换格式。许多训练框架(PyTorch、TensorFlow、MXNet等)都可以导出模型为ONNX格式,方便在不同推理引擎上运行。ONNX Runtime (ORT) 是微软主导的高性能推理引擎,支持ONNX模型加载并在多种硬件上优化执行。使用ONNX Runtime可以获得比框架直接推理更好的性能,因为ORT对计算图进行了优化(算子融合、内存复用等),并针对不同硬件有专门优化后端(CPU, GPU, OpenVINO, TensorRT 等)。例如,将PyTorch模型导出ONNX,用ORT执行通常能提升CPU推理速度。另外,ORT支持量化优化,可以把模型权重从FP32量化到INT8甚至更低精度,同时加速推理和减少内存占用,一般只需很小的精度损失。对于不要求极致低延迟的场景,ORT已经能满足大部分优化需求。部署上,ONNX模型跨平台统一非常方便,许多云服务也支持直接部署ONNX模型。

NVIDIA TensorRT: 这是NVIDIA提供的针对GPU的高性能推理库。它通过深入挖掘NVIDIA GPU架构特性,实现对模型计算图的极致优化,包括FP16/INT8精度降低,CUDA kernel融合和调度优化等。使用TensorRT通常可以使CNN类模型在GPU上的推理延迟减少一半以上,并支持Batching提高吞吐。TensorRT可以从ONNX模型导入,然后生成一个Engine(二进制优化后的模型)。相对而言TensorRT需要较多专业知识调试(比如校准INT8),但其性能对于部署大规模服务很关键。在高并发场景,也可以把TensorRT和 Triton Inference Server 结合。

Triton Inference Server: Nvidia Triton是一个开源的模型推理服务器框架,支持部署多种模型并发推理,自动批处理,支持HTTP/gRPC请求接口。Triton的优势是统一管理和高效利用GPU资源,可以托管TensorRT引擎、ONNX模型、TorchScript模型甚至Python自定义推理逻辑等。Triton能够对请求进行动态批处理(将短时间内多个请求组成一个批送入GPU推理,提高吞吐),并可以同时调度不同模型到不同设备或队列 (LoRA vs. QLoRA)。对于多模型服务或者多实例负载,Triton极大简化了部署。例如一个AI服务需要同时提供分类和检测模型,Triton可以配置两个模型端点,共享GPU且优化批处理。Triton也与Kubernetes等容器编排兼容,有prometheus监控,方便运维。总体来说,如果项目涉及在线实时推理且QPS高,Triton是一站式解决方案。

其它加速: 还有很多其他推理加速方向,如蒸馏(通过训练得到一个小模型以更快推理)、剪枝(移除不重要的网络连接降低计算量)、专用硬件(TPU、FPGA、NPU)等。对于Transformer模型的推理优化,有自定义CUDA Kernel(如FlashAttention针对长序列Attention优化) (What is vLLM: A Guide to Quick Inference),也有并行计算(模型并行拆分到多GPU推理超大模型)。如GPT-4这样超大模型一般需要分布式推理库和优化调度。对于序列生成类推理,也可以采用多段并行的方法(流水线生成,或多线程管理部分序列)。

工程实践: 提升推理性能往往是一系列技巧组合。常见流程:

1)尝试使用ONNX Runtime或者PyTorch自带的TorchScript,看看是否有明显提升;

2)在GPU上用TensorRT优化模型;

3)根据硬件条件考虑量化(8-bit或16-bit);

4)搭建批处理服务,如果流量模式支持批量,则吞吐会大增;

5)引入专门引擎如vLLM对特殊任务优化。

需要注意的是,不同模型、不同硬件效果不同,调优推理需要profiling。例如对CPU服务,优化内存布局cache命中重要;对GPU服务,优化kernel算子Fusion重要。还要平衡吞吐和延迟指标,有些优化提高吞吐会增加单请求延迟(如大batch)。因此根据SLA选择适当批大小和并发策略。

案例: 推理加速可以极大节省成本。例如某图像识别服务,原来一张V100 GPU每秒处理100张图片,引入TensorRT和批处理后可以达到400+张/秒,在满足延迟要求下,一台服务器的吞吐翻倍,相应地成本减半。再如大语言模型的API服务,如果用vLLM优化,达到同样token输出速率可以少用几张GPU甚至服务更多用户。这对大模型产品化商业意义重大。

多模态系统组件:WebRTC、FFmpeg 等

当构建一个多模态(例如涉及音视频)的AI应用时,除了机器学习模型本身,还需要用到一些传统的多媒体处理库和协议。WebRTC和FFmpeg是其中两种常见且重要的工具。我们介绍它们的作用和在多模态AI系统中的使用场景。

WebRTC(Web Real-Time Communication): WebRTC是一套支持浏览器和移动APP进行实时音视频通信的开源协议和API规范 (Reinforcement Learning Agents - MathWorks)。它的典型应用是网页视频聊天,无需安装插件,就能点对点传输视频/音频流。WebRTC提供了对音视频的获取(如摄像头、麦克风)、网络传输(穿透NAT、防火墙,使用UDP的SRTP流加密传输)以及简单编解码的能力。对于AI系统来说,如果要实现实时音视频交互,WebRTC是不可或缺的。比如一个AI助手需要和用户视频对话,那么在用户端可以用WebRTC捕获摄像头画面和麦克风声音,并传输到服务器AI;服务器处理后,将AI的语音和可能的虚拟形象视频实时推送回来,也通过WebRTC。WebRTC具备低延迟特性,非常适合交互场景。此外,WebRTC处理音频包括回声消除、噪声抑制等,这些对话音频质量提升技术也利于ASR模型的识别。

用WebRTC需要涉及信令流程去建立P2P连接,比如浏览器发出SDP信息,服务器可通过自己的信令服务器协调。很多AI应用不会让用户直连AI服务器(因服务器不直接用浏览器),通常采用一个中继(Selective Forwarding Unit, SFU)在云上转发流。有开源的WebRTC SFU实现如Jitsi、mediasoup等。如果不用WebRTC,也可以采用RTMP/RTSP等流协议,但WebRTC在浏览器原生支持是最大优势。对于开发者,要集成WebRTC可使用客户端SDK并搭建一个信令和转发服务。

FFmpeg: FFmpeg是一个功能极其强大的开源多媒体处理工具库,它包含了处理音频、视频、图像的一系列组件。FFmpeg最知名的是它的命令行工具,可用于转码、剪辑、录制等,但在开发中更关注其编程接口(libavcodec, libavformat等)。在多模态AI系统中,FFmpeg的作用主要包括:

- 格式解码:很多AI模型需要先把输入的音视频解码成原始的tensor。如做视频分析,需要将各种格式(MP4, MKV等)的文件读帧。FFmpeg支持海量编解码器(H.264, H.265, VP9...),可以将视频解码为逐帧图像,或者将音频解码为PCM波形数据,供模型处理。

- 格式编码:反过来,若AI系统生成了图像序列或音频,需要打包成视频或音频文件/流输出,也可用FFmpeg编码。比如TTS产生命令后的音频波形,用FFmpeg编码为MP3或Opus音频给客户端;或者将逐帧生成的图像用FFmpeg编码成MP4视频。

- 流处理:FFmpeg也能处理网络流媒体,支持RTMP推流、接收网络摄像头RTSP流等。在没有WebRTC的场景下,可以用FFmpeg读取视频流送进AI分析,再用FFmpeg推送结果流。

- 视频帧处理:FFmpeg内部还提供滤镜功能,能够做格式转换、缩放、叠加文本图片等操作。如果AI模型要求固定分辨率输入,可以用FFmpeg先缩放到合适大小。或检测到人脸后,用FFmpeg给源视频加标记框等。

FFmpeg因为是用C写的,非常高效,也能借助GPU(如NVENC/NVDEC加速编解码)。AI工程中常常有例如“收到用户上传的一段视频,先用FFmpeg抽帧(或提取音频)、送入模型识别人物、再把结果烧录进视频”这样的需求。FFmpeg完全能够胜任这些处理。

与AI框架集成: 有时AI框架会内置对FFmpeg的调用,如OpenCV的VideoCapture模块其实内部就使用FFmpeg来读写视频。对于语音处理,许多ASR工具使用FFmpeg或SoX将各种格式音频转为16k pcm。WebRTC类似,有的AI SDK封装了WebRTC让你方便地拿到实时音频帧。

使用背景: 开发者需要知道,虽然AI模型可以处理音视频,但数据获取和输出离不开传统多媒体库。WebRTC解决实时互动,FFmpeg解决格式兼容和离线批处理。学会用FFmpeg命令行调试各种转码,也有助于明确AI模型输入输出的正确性(例如要确认输出音频采样率、声道等符合TTS要求)。另外注意版权和专利问题:FFmpeg包含很多编解码器在部分国家受专利保护,商业应用需要留意许可。

其他组件: 类似的还有GStreamer(另一套多媒体流框架,更模块化,可搭建复杂流媒体管道),SoX(老牌声音处理工具),PortAudio(跨平台音频IO库)等。这些可能在不同语言或平台上有用。手机应用里则有iOS的AVFoundation,Android的MediaCodec等提供相应功能。

案例: 一个典型AI应用:做一个实时手语翻译,用户通过浏览器摄像头出视频,AI识别手语并用语音回答。这个系统里,前端用WebRTC捕获视频上传;服务端WebRTC解码出视频帧,用深度学习模型做手势识别/分类;然后NLP模型将识别结果转成文字,再TTS成语音;最后服务端通过WebRTC的音频通道将语音传回前端播放。在这个过程中,WebRTC承担了流媒体传输,FFmpeg则可能用于在云端对视频进行预处理(如转成统一帧率、分辨率)和将生成语音压缩成Opus编码的包。这说明在复杂多模态应用里,这些技术扮演连接模型与现实环境的桥梁。

综上,WebRTC、FFmpeg等多媒体技术是构建多模态AI系统的基础设施。机器学习算法处理的是数字矩阵,而WebRTC/FFmpeg帮助把现实世界的视听信号变成这些矩阵,或反之输出可供人类感知的媒体。合格的AI工程师需要对这些工具有所了解,才能将模型真正应用到端到端的产品中。

学习资源推荐

机器学习领域知识庞杂、发展快速,持续学习和实践非常重要。这里按类别推荐一些高质量的学习资源,包括课程、书籍论文、项目实践和社区博客等,帮助读者构建更深入和广泛的知识体系。

精品课程与教材

- Andrew Ng 的机器学习课程(Stanford CS229 / Coursera Machine Learning): 机器学习入门经典课程。Ng老师的Coursera机器学习课偏重基础概念和方法(覆盖线性回归、逻辑回归、树、聚类、降维等),适合入门 (机器学习主要类型(五):系列总结_思维导图(监督学习 - CSDN博客)。斯坦福CS229则内容更深入,包括优化、EM算法、HMM、SVM等细节,配套的讲义和习题质量很高,可配合Ng老师的讲义或公开笔记学习。

- Stanford CS231n – 卷积神经网络与视觉识别: 由 Fei-Fei Li 等教授的课程,专注CNN和计算机视觉 (卷积神经网络(CNN)基础及经典模型介绍 - 知乎专栏)。课程涵盖了卷积网络原理、经典CNN架构、检测分割和视觉任务,配有Python作业从零实现CNN,非常锻炼深度学习基础。其公开课件和作业(如Tiny ImageNet分类)很出名。

- Stanford CS224n – 自然语言处理(含深度学习): 由 Richard Socher 等教授的NLP课程,从词向量、RNN到Transformer、预训练模型,体系完整。作业会实现word2vec、seq2seq翻译等,有助于理解NLP模型细节。结合今年的大模型进展,可以看新版课程视频。

- Deep Learning Specialization (deeplearning.ai): Andrew Ng团队制作的深度学习系列Coursera课程,包括5门:神经网络基础、改善深度模型、结构化机器学习项目、CNN、RNN。这系列对实践友好,每门都有编码作业,涵盖BatchNorm、正则、ResNet、LSTM等实战技巧。对于初学者快速掌握深度学习实操很有帮助。

- fast.ai 免费课程: fast.ai的两部分课程(“Practical Deep Learning for Coders”和“Deep Learning for Coders Part 2”)强调实践和高层理解。Jeremy Howard授课,使用fastai库,两个月即可训练强大的模型。课程以案例驱动(如影评分类、图像识别、Tabular数据),适合有编程经验的人快速上手深度学习项目。

- 吴恩达 Deep Learning 笔记 & 李宏毅 机器学习课程: 中文社区中,吴恩达老师的深度学习课程有官方中文版,网上也有笔记;台湾李宏毅教授每年公开的机器学习课程(含深度学习)口碑很好 (机器学习主要类型(五):系列总结_思维导图(监督学习 - CSDN博客)。李宏毅课程覆盖强化学习、生成模型等,也推荐观看。

- 《动手学深度学习》(Dive into Deep Learning): 一本开源的交互式教材,有中英文版 (6. 卷积神经网络 - 动手学深度学习)。由李沐等编写,使用PyTorch/MXNet实现,每章配套练习。它内容涵盖线性模型、CNN、RNN、Transformer、概率模型等,非常适合自学,边学边代码实践。

经典书籍与论文

-

《Pattern Recognition and Machine Learning》(PRML): 俗称“PRML”或“西瓜书”的英文版(作者Bishop)。系统介绍机器学习概率模型基础,包括贝叶斯推断、EM算法、卡尔曼滤波等。对于想理解ML理论基础的读者,此书是圣经级别。

-

《Deep Learning》(Ian Goodfellow 等): 深度学习领域的权威教材,涵盖从基础神经网络到CNN、RNN、生成模型、表示学习等各方面。理论推导详细,还包括优化、高级主题。适合作为深度学习的理论补充阅读。

-

《机器学习》周志华: 中文经典教材,被称为“西瓜书”。内容覆盖广泛,从基本算法到集成学习、核方法、图学习等。理论性较强,适合作为进阶学习的参考 (机器学习主要类型(五):系列总结_思维导图(监督学习 - CSDN博客)。书中练习题也具挑战性。

-

重要论文:机器学习经典论文很多,可根据兴趣选择阅读:

- 神经网络与深度学习:Hinton的BP算法论文(1986)、LeCun的LeNet论文(1998)、Krizhevsky的AlexNet论文(2012) (7.6. Convolutional Neural Networks (LeNet) — Dive into Deep Learning 1.0.3 documentation)、He等的ResNet论文(2015)。

- NLP:Mikolov的word2vec两篇(2013)、Vaswani的Transformer论文“Attention is All You Need”(2017)、Devlin的BERT论文(2018)等。

- 强化学习:Watkins的Q-Learning(1992)、Mnih的DQN论文(2015)、Silver的AlphaGo论文(2016)等。

- 生成模型:Goodfellow的GAN论文(2014)、Ho的扩散模型DDPM论文(2020)等。

阅读论文能了解算法来源及作者思路,对深入研究有帮助。开始可以从近年的综述论文(survey)入手,获得全景再选重点。

实践项目与竞赛

- Kaggle: 数据科学竞赛平台Kaggle提供了海量实践机会。从入门(泰坦尼克生存预测)到高级比赛,涵盖各领域。参与Kaggle比赛能练习从特征工程、模型调参到结果分析的全流程。Kaggle讨论区也有许多优秀解决方案学习。即使不比赛,可以挑感兴趣的数据集做小项目练习。

- 开源项目: GitHub上有很多机器学习实战项目可以跟做。例如:

- scikit-learn 官方教程:用sklearn实现各种算法demo,巩固基础算法应用。

- yolo系列实现:如ultralytics的yolov5项目,学目标检测的工程细节。

- transformers库例子:HuggingFace Transformers提供了丰富的NLP模型例子(文本分类、问答、翻译等),跟着练习有助于掌握预训练模型微调。

- fast-reid(目标重识别)、detectron2(Facebook的CV工具集)等大型项目,也值得阅读源码了解工业级实现。

- 毕业设计/科研项目: 对于学生,可以把机器学习应用到领域课题中,如做一个简易OCR系统、训练一个对话机器人、或将ML用于物联网数据分析等。实践中遇到问题再查资料解决,进步很快。

- 竞赛: 除Kaggle,国内的天池比赛、DataCastle等也提供锻炼机会。还有一些算法挑战如ImageNet、COCO竞赛可关注顶尖方案。参加比赛能逼你优化到极致,并学到他人思路。

- 贡献开源: 选择一个常用的ML开源库(如scikit-learn, PyTorch, TensorFlow, transformers等),尝试给它提交小的贡献(文档、bug修复、优化)。这个过程会加深你对工具内部工作原理的理解,也能接触到优秀开发者的评审反馈。

博客、社区与视频

- Arxiv和paperswithcode: 跟踪最新研究,可以定期浏览Arxiv机器学习板块和paperswithcode网站。后者为论文提供代码链接和结果比较,很方便了解最新SOTA进展。可以每周看几篇感兴趣的摘要。

- Medium / 博客: 国外许多工程师和研究者在Medium或个人博客分享通俗文章。例如:

- Andrej Karpathy's blog:如“Neural Networks: Zero to Hero”系列、对RNN的讲解等,深入浅出。

- Chris Olah:可视化解释神经网络的文章(如理解卷积网络、反卷积等)。

- Sebastian Ruder:他写的NLP进展综述、优化技巧讲解都很经典。

- Stanford CS230深度学习笔记:很多学生在GitHub上公开了课程笔记,涵盖实践经验。

- 中文博客: 知乎上许多高赞回答科普ML概念。像“机器学习初学者指南”、“深度学习进阶”这类专栏值得一看。另外OneFlow社区、PaddlePaddle社区的技术博客也有实践分享。李rumor的公众号、AI公论等发布业界动态。

- 视频资源: 除课程录像外,YouTube/B站上有一些优秀科普视频:

- 3Blue1Brown的神经网络系列(用动画讲解反向传播原理,非常直观)。

- StatQuest (Josh Starmer) 的视频,把复杂算法讲得通俗易懂,配合他独特的手绘插图(推荐决策树、随机森林、PCA等讲解)。

- Two Minute Papers:快速了解新论文,每期两三分钟讲述新奇的研究成果,趣味性强。

- 李宏毅机器学习课程的录像(B站有全套,还有中文字幕),他讲解风趣、例子丰富。

- 社区问答: 遇到疑问时,可上Stack Overflow、SegmentFault等提问搜索。在Kaggle论坛、GitHub issues寻求特定模型/比赛的问题解答。多和社区交流,往往能获得宝贵经验。

- 公众号/订阅号: 例如机器之心、量子位,会推送行业新闻和论文解读,可以关注动态但要保持批判思考,避免被炒作噱头迷惑。

最后,理论和实践齐头并进非常关键。在学习过程中,建议以一个自己感兴趣的小项目为牵引,将上面推荐的知识应用其中。这篇综述提供了较全面的指引,但机器学习领域广袤而动态,不可能面面俱到。希望读者能通过持续的学习和动手,不断深化理解,紧跟技术发展,真正掌握将机器学习应用于实际问题的本领。

总结: 机器学习的学习之路充满挑战亦充满收获。从基础概念、经典算法,到深度学习网络和前沿应用,每一步都需要扎实掌握和刻苦练习。本综述为您梳理了一个系统的知识结构,并提供了进一步探索的资源。接下来,建议您制定学习计划,循序渐进地研读和实验。遇到困难时回顾基础,多手画推导、多上机验证。通过理论与实践结合,您一定能够在机器学习领域取得长足进步。祝愿您学有所成,在未来的项目中灵活运用所学,解决实际问题,让机器学习的强大力量真正为您所用。加油!